一、系统环境

- 操作系统:Rocky Linux 9.3

- 内核版本:5.14.0-284.11.1.el9_2.x86_64

- 容器运行时:Docker + CRI-Docker

- Kubernetes 版本:1.29.2

- 网络插件:Calico

二、集群规划

基于二进制安装包,部署三主两从的高可用集群。

| 主机名称 | IPV4地址 | CPU/内存/磁盘 | 说明 | 软件 |

|---|---|---|---|---|

| 10.20.1.203 | 2C/4G/200G | 外网节点(可翻墙) | 下载各种所需安装包 | |

| Master01 | 10.20.1.101 | 2C/4G/200G | master节点 | apiserver、controller-manager、scheduler、etcd、 kubelet、kube-proxy、nginx |

| Master02 | 10.20.1.102 | 2C/4G/200G | master节点 | apiserver、controller-manager、scheduler、etcd、 kubelet、kube-proxy、nginx |

| Master03 | 10.20.1.103 | 2C/4G/200G | master节点 | apiserver、controller-manager、scheduler、etcd、 kubelet、kube-proxy、nginx |

| Node01 | 10.20.1.104 | 2C/4G/200G | node节点 | kubelet、kube-proxy、nginx |

| Node02 | 10.20.1.105 | 2C/4G/200G | node节点 | kubelet、kube-proxy、nginx |

三、基础环境配置(所有节点)

1. 主机名设置

设置集群中各个节点的主机名

Master01 节点

hostnamectl set-hostname k8s-master01Master02 节点

hostnamectl set-hostname k8s-master02Master03 节点

hostnamectl set-hostname k8s-master03Node01 节点

hostnamectl set-hostname k8s-node01Node02 节点

hostnamectl set-hostname k8s-node022. 配置静态IP

集群内的每个几点都需要配置唯一的IP地址,这里同时配置了 IPV4地址 和 IPV6地址。

Master01 节点

[root@k8s-master01 ~]# cat /etc/NetworkManager/system-connections/ens34.nmconnection

[ipv4]

method=manual

address1=10.20.1.101/24;10.20.1.1

dns=61.132.163.68;114.114.114.114

[ipv6]

method=manual

addresses=2400:3200::101/64

gateway=2400:3200::1

dns=2400:3200::1;2400:3200:baba::1;2001:4860:4860::8888;2001:4860:4860::8844Master02 节点

[root@k8s-master02 ~]# cat /etc/NetworkManager/system-connections/ens34.nmconnection

[ipv4]

method=manual

address1=10.20.1.102/24;10.20.1.1

dns=61.132.163.68;114.114.114.114

[ipv6]

method=manual

addresses=2400:3200::102/64

gateway=2400:3200::1

dns=2400:3200::1;2400:3200:baba::1;2001:4860:4860::8888;2001:4860:4860::8844Master03 节点

[root@k8s-master03 ~]# cat /etc/NetworkManager/system-connections/ens34.nmconnection

[ipv4]

method=manual

address1=10.20.1.103/24;10.20.1.1

dns=61.132.163.68;114.114.114.114

[ipv6]

method=manual

addresses=2400:3200::103/64

gateway=2400:3200::1

dns=2400:3200::1;2400:3200:baba::1;2001:4860:4860::8888;2001:4860:4860::8844Node01 节点

[root@k8s-node01 ~]# cat /etc/NetworkManager/system-connections/ens34.nmconnection

[ipv4]

method=manual

address1=10.20.1.104/24;10.20.1.1

dns=61.132.163.68;114.114.114.114

[ipv6]

method=manual

addresses=2400:3200::104/64

gateway=2400:3200::1

dns=2400:3200::1;2400:3200:baba::1;2001:4860:4860::8888;2001:4860:4860::8844Node02 节点

[root@k8s-node02 ~]# cat /etc/NetworkManager/system-connections/ens34.nmconnection

[ipv4]

method=manual

address1=10.20.1.105/24;10.20.1.1

dns=61.132.163.68;114.114.114.114

[ipv6]

method=manual

addresses=2400:3200::105/64

gateway=2400:3200::1

dns=2400:3200::1;2400:3200:baba::1;2001:4860:4860::8888;2001:4860:4860::88443. 修改hosts文件

配置集群各节点 hostname 和 ip 的映射

cat >> /etc/hosts << "EOF"

10.20.1.101 k8s-master01 m1

10.20.1.102 k8s-master02 m2

10.20.1.103 k8s-master03 m3

10.20.1.104 k8s-node01 n1

10.20.1.105 k8s-node02 n2

2400:3200::101 k8s-master01 m1

2400:3200::102 k8s-master02 m2

2400:3200::103 k8s-master03 m3

2400:3200::104 k8s-node01 n1

2400:3200::105 k8s-node02 n2

EOF验证 hosts 文件配置

cat /etc/hosts

ping k8s-master01 -c 4 # 默认使用 IPv4

ping6 k8s-master01 -c 4 # 使用 IPv64. 修改终端颜色

这里只是修改shell终端显示文本的颜色,非必要步骤。

cat << EOF >> ~/.bashrc

PS1="\[\e[37;47m\][\[\e[32;47m\]\u\[\e[34;47m\]@\h \[\e[36;47m\]\w\[\e[0m\]]\\$ "

EOF

# 让修改立即见效

source ~/.bashrc命令解析:

这段命令用于修改当前用户的 Bash Shell 提示符(

PS1),并将其设置写入到~/.bashrc文件中,以便在每次登录或启动 Shell 时自动加载该配置。PS1="..." 定义 Shell 的主提示符格式(Prompt String 1),即你在终端中输入命令时显示的提示符。最终效果如下:

5. 更换系统软件源

将 Rocky 默认源替换成阿里源,提升软件安装速度。

# 更新源

sed -e 's|^mirrorlist=|#mirrorlist=|g' \

-e 's|^#baseurl=http://dl.rockylinux.org/$contentdir|baseurl=https://mirrors.aliyun.com/rockylinux|g' \

-i.bak /etc/yum.repos.d/[Rr]ocky*.repo

# 刷新dnf缓存

dnf makecache

# 验证源更新

dnf repolist命令解析:

# 使用 sed 命令修改 Rocky Linux 的 YUM/DNF 源配置文件,切换到阿里云的镜像源。 sed -e 's|^mirrorlist=|#mirrorlist=|g' \ -e 's|^#baseurl=http://dl.rockylinux.org/$contentdir|baseurl=https://mirrors.aliyun.com/rockylinux|g' \ -i.bak /etc/yum.repos.d/[Rr]ocky*.repo # 将以 mirrorlist= 开头的行注释掉(在前面加 #) -e 's|^mirrorlist=|#mirrorlist=|g' # 将以 #baseurl= 开头并指向默认 Rocky Linux 源的行取消注释,并替换为阿里云镜像源 URL。 's|^#baseurl=http://dl.rockylinux.org/$contentdir|baseurl=https://mirrors.aliyun.com/rockylinux|g' # -i.bak:直接修改文件,并为原文件创建备份(扩展名为 .bak)。 # 修改 /etc/yum.repos.d/ 目录下所有以 rocky 或 Rocky 开头的 .repo 文件。 # 修改完成后,原始文件会被备份为 .bak 文件。 -i.bak /etc/yum.repos.d/[Rr]ocky*.repo # 更新本地缓存,确保系统可以快速查询软件包信息。 dnf makecache

6. 修改防火墙

关闭默认防火墙firewalld,配置 iptables 防火墙

systemctl stop firewalld

systemctl disable firewalld

yum -y install iptables-services

systemctl start iptables

iptables -F

systemctl enable iptables

service iptables save命令解析:

# 停止运行 firewalld systemctl stop firewalld # 禁止 firewalld 开机自启 systemctl disable firewalld # 安装 iptables 服务,用于管理 Linux 的防火墙规则 yum -y install iptables-services # 使防火墙规则立即生效,并开始运行 iptables 防火墙服务。 systemctl start iptables # 删除当前的防火墙规则,通常用于重置或清理防火墙规则。 iptables -F # 设置 iptables 服务开机自启动,确保服务器重启后,iptables 服务会自动加载防火墙规则。 systemctl enable iptables # 将当前 iptables 的规则配置保存到文件中(通常是 /etc/sysconfig/iptables),以便在系统重启或 iptables 服务重新启动后,能够自动加载保存的规则。 service iptables save

7. 禁用 Selinux

setenforce 0

sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

grubby --update-kernel ALL --args selinux=0命令解析:

# 将 SELinux 的模式设置为 Permissive(宽容模式)。 # 0:表示设置为 Permissive 模式,此模式下 SELinux 不会强制执行安全策略,而是记录违规日志。 # 1:表示 Enforcing 模式,此模式下 SELinux 会强制执行安全策略。 setenforce 0 # 修改 SELinux 配置文件 /etc/selinux/config,将 SELINUX 设置为 disabled。永久禁用 SELinux,即使系统重启也不会再启用。 sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config # 通过 grubby 工具将 selinux=0 参数添加到所有内核启动配置中。 grubby --update-kernel ALL --args selinux=0 grubby --info DEFAULT # 查看是否禁用, grubby --info DEFAULT # 回滚内核层禁用操作,、 grubby --update-kernel ALL --remove-args selinux

8. 设置时区

timedatectl set-timezone Asia/Shanghai9. 关闭 swap 分区

swapoff -a

sed -i 's:/dev/mapper/rl-swap:#/dev/mapper/rl-swap:g' /etc/fstab命令解析:

# 立即关闭系统中所有的交换分区 swapoff -a # 注释掉 /etc/fstab 文件中定义的交换分区挂载条目,防止系统在重启后重新启用交换分区。 sed -i 's:/dev/mapper/rl-swap:#/dev/mapper/rl-swap:g' /etc/fstab # 验证交换分区是否关系 free -h 输出中 Swap 一栏的值会变为 0。

10. 安装基本工具

dnf -y install openssh-server wget tree bash-completion psmisc vim net-tools lrzsz nfs-utils epel-release telnet rsync yum-utils device-mapper-persistent-data lvm2 git tar curl11. 修改系统最大打开文件数

cat >> /etc/security/limits.conf <<EOF

* soft nofile 655360

* hard nofile 131072

* soft nproc 655350

* hard nproc 655350

* soft memlock unlimited

* hard memlock unlimited

EOF

echo "ulimit -SHn 65535" >> /etc/profile

source /etc/profile命令解析:

soft nofile 655360

soft表示软限制,nofile 表示一个进程可打开的最大文件数,默认值为1024。这里的软限制设置为655360,即一个进程可打开的最大文件数为655360。hard nofile 131072

hard表示硬限制,即系统设置的最大值。nofile表示一个进程可打开的最大文件数,默认值为4096。这里的硬限制设置为131072,即系统设置的最大文件数为131072。soft nproc 655350

soft表示软限制,nproc表示一个用户可创建的最大进程数,默认值为30720。这里的软限制设置为655350,即一个用户可创建的最大进程数为655350。hard nproc 655350

hard表示硬限制,即系统设置的最大值。nproc表示一个用户可创建的最大进程数,默认值为4096。这里的硬限制设置为655350,即系统设置的最大进程数为655350。soft memlock unlimited

seft表示软限制,memlock表示一个进程可锁定在RAM中的最大内存,默认值为64 KB。这里的软限制设置为unlimited,即一个进程可锁定的最大内存为无限制。hard memlock unlimited

hard表示硬限制,即系统设置的最大值。memlock表示一个进程可锁定在RAM中的最大内存,默认值为64 KB。这里的硬限制设置为unlimited,即系统设置的最大内存锁定为无限制。

12. 安装 ipvs

# 安装 ipvs

yum install ipvsadm ipset sysstat conntrack libseccomp -y

cat >> /etc/modules-load.d/ipvs.conf <<EOF

ip_vs

ip_vs_rr

ip_vs_wrr

ip_vs_sh

nf_conntrack

ip_tables

ip_set

xt_set

ipt_set

ipt_rpfilter

ipt_REJECT

ipip

EOF

systemctl restart systemd-modules-load.service

lsmod | grep -e ip_vs -e nf_conntrack命名解析:

ipvsadm 命令行工具,用于管理IPVS(IP Virtual Server)

ipset 内核级工具,用于高效管理IP地址、端口或MAC地址的集合(sets)

sysstat 系统性能监控工具包,包括sar、iostat、mpstat等命令,用于收集和报告CPU、内存、磁盘I/O、网络等系统统计数据

conntrack 命令行工具(conntrack-tools的一部分),用于管理Netfilter的连接跟踪表(connection tracking table)

libseccomp 这是一个库,用于支持seccomp(Secure Computing Mode),seccomp是Linux内核功能,用于限制进程的系统调用(syscall),从而增强安全性(如沙箱化)

cat >> ….. 显示的加载内核模块

- ip_vs 核心IPVS模块,提供虚拟服务器功能,用于L4负载均衡

- ip_vs_rr IPVS的 round-robin 调度算法模块(轮询)

- ip_vs_wrr IPVS的 weighted round-robin 调度算法模块(加权轮询)

- ip_vs_sh IPVS的 source hashing 调度算法模块(源地址哈希)

- nf_conntrack Netfilter连接跟踪模块,跟踪网络连接状态(用于NAT和防火墙)

- ip_tables iptables的核心模块,用于IPv4包过滤和NAT

- ip_set IP集合管理模块,支持高效的IP列表处理

- xt_set iptables的扩展模块,用于与ip_set集成

- ipt_set iptables的set匹配模块(类似xt_set,但特定于IPv4)

- ipt_rpfilter iptables的反向路径过滤模块,防止IP欺骗攻击

- ipt_REJECT iptables的REJECT目标模块,用于拒绝包并发送拒绝消息

- ipip 隧道模块,用于封装IP包(类似VPN隧道)

systemctl restart systemd-modules-load.service:立即加载这些模块(因为/etc/modules-load.d/目录下的.conf文件会被systemd-modules-load服务读取)

lsmod | grep -e ip_vs -e nf_conntrack:检查模块是否加载成功。

13. 开启路由转发

echo 'net.ipv4.ip_forward=1' >> /etc/sysctl.conf

sysctl -p14. 排除 calico 网卡被 NetworkManager 所管理

cat > /etc/NetworkManager/conf.d/calico.conf << EOF

[keyfile]

unmanaged-devices=interface-name:cali*;interface-name:tunl*;interface-name:vxlan.calico;interface-name:vxlan-v6.calico;interface-name:wireguard.cali;interface-name:wg-v6.cali

EOF

systemctl restart NetworkManager命令解析:

这个参数用于指定不由 NetworkManager 管理的设备。它由以下两个部分组成 interface-name:cali* 表示以 "cali" 开头的接口名称被排除在 NetworkManager 管理之外。例如,"cali0", "cali1" 等接口不受 NetworkManager 管理 interface-name:tunl* 表示以 "tunl" 开头的接口名称被排除在 NetworkManager 管理之外。例如,"tunl0", "tunl1" 等接口不受 NetworkManager 管理 interface-name:vxlan.calico 匹配名为vxlan.calico的接口,Calico在VXLAN模式下可能使用该接口名进行跨节点通信(VXLAN是一种覆盖网络技术) interface-name:vxlan-v6.calico 匹配名为vxlan-v6.calico的接口,这是Calico在支持IPv6的VXLAN模式下使用的接口名 interface-name:wireguard.cali 匹配名为wireguard.cali的接口,Calico支持使用WireGuard(一种高性能VPN协议)进行加密通信,这个接口用于WireGuard隧道。 interface-name:wg-v6.cali 匹配名为wg-v6.cali的接口,这是Calico在IPv6网络中使用的WireGuard接口 通过使用这个参数,可以将特定的接口排除在 NetworkManager 的管理范围之外,以便其他工具或进程可以独立地管理和配置这些接口

15. 修改内核参数

cat > /etc/sysctl.d/k8s.conf << EOF

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-iptables = 1

fs.may_detach_mounts = 1

vm.overcommit_memory=1

vm.panic_on_oom=0

fs.inotify.max_user_watches=89100

fs.file-max=52706963

fs.nr_open=52706963

net.netfilter.nf_conntrack_max=2310720

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_keepalive_intvl =15

net.ipv4.tcp_max_tw_buckets = 36000

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_orphans = 327680

net.ipv4.tcp_orphan_retries = 3

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.ip_conntrack_max = 65536

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.tcp_timestamps = 0

net.core.somaxconn = 16384

net.ipv6.conf.all.disable_ipv6 = 0

net.ipv6.conf.default.disable_ipv6 = 0

net.ipv6.conf.lo.disable_ipv6 = 0

net.ipv6.conf.all.forwarding = 1

EOF

sysctl --system命令解析:

这些是Linux系统的一些参数设置,用于配置和优化网络、文件系统和虚拟内存等方面的功能。以下是每个参数的详细解释: net.ipv4.ip_forward = 1 这个参数启用了IPv4的IP转发功能,允许服务器作为网络路由器转发数据包。 net.bridge.bridge-nf-call-iptables = 1 当使用网络桥接技术时,将数据包传递到iptables进行处理。 fs.may_detach_mounts = 1 允许在挂载文件系统时,允许被其他进程使用。 vm.overcommit_memory=1 该设置允许原始的内存过量分配策略,当系统的内存已经被完全使用时,系统仍然会分配额外的内存。 vm.panic_on_oom=0 当系统内存不足(OOM)时,禁用系统崩溃和重启。 fs.inotify.max_user_watches=89100 设置系统允许一个用户的inotify实例可以监控的文件数目的上限。 fs.file-max=52706963 设置系统同时打开的文件数的上限。 fs.nr_open=52706963 设置系统同时打开的文件描述符数的上限。 net.netfilter.nf_conntrack_max=2310720 设置系统可以创建的网络连接跟踪表项的最大数量。 net.ipv4.tcp_keepalive_time = 600 设置TCP套接字的空闲超时时间(秒),超过该时间没有活动数据时,内核会发送心跳包。 net.ipv4.tcp_keepalive_probes = 3 设置未收到响应的TCP心跳探测次数。 net.ipv4.tcp_keepalive_intvl = 15 设置TCP心跳探测的时间间隔(秒)。 net.ipv4.tcp_max_tw_buckets = 36000 设置系统可以使用的TIME_WAIT套接字的最大数量。 net.ipv4.tcp_tw_reuse = 1 启用TIME_WAIT套接字的重新利用,允许新的套接字使用旧的TIME_WAIT套接字。 net.ipv4.tcp_max_orphans = 327680 设置系统可以同时存在的TCP套接字垃圾回收包裹数的最大数量。 net.ipv4.tcp_orphan_retries = 3 设置系统对于孤立的TCP套接字的重试次数。 net.ipv4.tcp_syncookies = 1 启用TCP SYN cookies保护,用于防止SYN洪泛攻击。 net.ipv4.tcp_max_syn_backlog = 16384 设置新的TCP连接的半连接数(半连接队列)的最大长度。 net.ipv4.ip_conntrack_max = 65536 设置系统可以创建的网络连接跟踪表项的最大数量。 net.ipv4.tcp_timestamps = 0 关闭TCP时间戳功能,用于提供更好的安全性。 net.core.somaxconn = 16384 设置系统核心层的连接队列的最大值。 net.ipv6.conf.all.disable_ipv6 = 0 启用IPv6协议。 net.ipv6.conf.default.disable_ipv6 = 0 启用IPv6协议。 net.ipv6.conf.lo.disable_ipv6 = 0 启用IPv6协议。 net.ipv6.conf.all.forwarding = 1 允许IPv6数据包转发。

16. 集群时间同步设置

在3主2从的集群环境中,配置3台 master 节点向使用 chony 通过外部网络同步时间校正自身的时间,并作为时间主服务器给集群中的其它 node 节点校正时间。

主节点时间权重不同

Master01 节点

yum install chrony -y

cat > /etc/chrony.conf << EOF

pool ntp1.aliyun.com iburst

pool ntp2.aliyun.com iburst

pool ntp3.aliyun.com iburst

pool ntp4.aliyun.com iburst

driftfile /var/lib/chrony/drift

makestep 1.0 3

rtcsync

allow 10.20.1.0/24

local stratum 10

keyfile /etc/chrony.keys

leapsectz right/UTC

logdir /var/log/chrony

EOF

systemctl restart chronyd ; systemctl enable chronyd命令解析:

pool ntp.aliyun.com iburst 指定使用ntp.aliyun.com作为时间服务器池,iburst选项表示在初始同步时会发送多个请求以加快同步速度。 driftfile /var/lib/chrony/drift 指定用于保存时钟漂移信息的文件路径。 makestep 1.0 3 设置当系统时间与服务器时间偏差大于1秒时,会以1秒的步长进行调整。如果偏差超过3秒,则立即进行时间调整。 rtcsync 启用硬件时钟同步功能,可以提高时钟的准确性。 allow 10.20.1.0/24 允许10.20.1.0/24网段范围内的主机与chrony进行时间同步。 local stratum 10 将本地时钟设为stratum 10,stratum值表示时钟的准确度,值越小表示准确度越高。 keyfile /etc/chrony.keys 指定使用的密钥文件路径,用于对时间同步进行身份验证。 leapsectz right/UTC 指定时区为UTC。 logdir /var/log/chrony 指定日志文件存放目录。

Master02 节点

yum install chrony -y

cat > /etc/chrony.conf << EOF

pool ntp1.aliyun.com iburst

pool ntp2.aliyun.com iburst

pool ntp3.aliyun.com iburst

pool ntp4.aliyun.com iburst

driftfile /var/lib/chrony/drift

makestep 1.0 3

rtcsync

allow 10.20.1.0/24

local stratum 12

keyfile /etc/chrony.keys

leapsectz right/UTC

logdir /var/log/chrony

EOF

systemctl restart chronyd ; systemctl enable chronydMaster03 节点

yum install chrony -y

cat > /etc/chrony.conf << EOF

pool ntp1.aliyun.com iburst

pool ntp2.aliyun.com iburst

pool ntp3.aliyun.com iburst

pool ntp4.aliyun.com iburst

driftfile /var/lib/chrony/drift

makestep 1.0 3

rtcsync

allow 10.20.1.0/24

local stratum 15

keyfile /etc/chrony.keys

leapsectz right/UTC

logdir /var/log/chrony

EOF

systemctl restart chronyd ; systemctl enable chronydNode01节点 和 Node02节点

yum install chrony -y

cat > /etc/chrony.conf << EOF

pool 10.20.1.101 iburst

pool 10.20.1.102 iburst

pool 10.20.1.103 iburst

driftfile /var/lib/chrony/drift

makestep 1.0 3

rtcsync

keyfile /etc/chrony.keys

leapsectz right/UTC

logdir /var/log/chrony

EOF

systemctl restart chronyd ; systemctl enable chronyd

#使用客户端进行验证

chronyc sources -v17. 配置免密登录

配置 k8s-master01 节点免密登录到其它节点,方便后续从 master01 节点往其它节点发送文件。

master-01

yum install -y expect

ssh-keygen -t rsa -P "" -f /root/.ssh/id_rsa

export user=root

export pass=123456

host=(k8s-master01 k8s-master02 k8s-master03 k8s-node01 k8s-node02 m1 m2 m3 n1 n2)

for host in ${host[@]};do expect -c "

spawn ssh-copy-id -i /root/.ssh/id_rsa.pub $user@$host

expect {

\"*yes/no*\" {send \"yes\r\"; exp_continue}

\"*password*\" {send \"$pass\r\"; exp_continue}

\"*Password*\" {send \"$pass\r\";}

}";

done命令解析:

# 一个自动化交互工具,用于处理需要用户输入的命令行交互 yum install -y expect # 生成RSA类型的SSH密钥对(公钥和私钥),并存储在指定路径。-P "":设置空密码(无口令保护),便于自动化使用 ssh-keygen -t rsa -P "" -f /root/.ssh/id_rsa export user=root export pass=123456 # 定义一个Bash数组host,包含集群中所有节点的主机名和别名 host=(k8s-master01 k8s-master02 k8s-master03 k8s-node01 k8s-node02) # 遍历host数组,对每个节点执行expect脚本 for host in ${host[@]};do expect -c " # 启动ssh-copy-id命令,将公钥文件/root/.ssh/id_rsa.pub分发到目标节点 spawn ssh-copy-id -i /root/.ssh/id_rsa.pub $user@$host expect { # 匹配:当ssh-copy-id提示是否信任目标主机 # 动作:发送yes并换行(\r),确认连接 # exp_continue:继续匹配后续模式(不退出expect) \"*yes/no*\" {send \"yes\r\"; exp_continue} # 匹配:当提示输入密码(大写Password) # 动作:发送变量$pass(即123456)并换行 # exp_continue:继续匹配后续模式。 \"*password*\" {send \"$pass\r\"; exp_continue} \"*Password*\" {send \"$pass\r\";} }"; done

18. 安装 Docker

18.1 安装 Docker 二进制包

k8s-master01

# 二进制包下载地址:https://download.docker.com/linux/static/stable/x86_64/

# 创建目录,后续下载的文件都放在这里

mkdir -p /opt/software/ /opt/module/ && chmod 777 -R /opt/software/ /opt/module/

# 更新 openssh-server

dnf -y install openssh-server

# 下载 Docker

wget https://download.docker.com/linux/static/stable/x86_64/docker-28.4.0.tgz

# 解压二进制包

tar xf docker-*.tgz

# 拷贝解压后的二进制包到 /usr/bin 目录下

cp docker/* /usr/bin/

# 将 Docker 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" docker/* $user@$i:/usr/bin/;

done

# 验证

$ docker --version

Docker version 28.4.0, build d8eb465

# 查看 containerd 版本

$ containerd --version

containerd github.com/containerd/containerd v1.7.28 b98a3aace656320842a23f4a392a33f46af9786618.2 配置 containerd.service

containerd 的作用:它是一个独立的守护进程(daemon),处理低级任务,如镜像拉取、容器启动/停止、快照管理、网络/存储挂载等。它基于 OCI(Open Container Initiative)标准,与 runC(Docker 的另一个组件,用于实际执行容器)协作。

dockerd 的作用:Docker Daemon (dockerd) 不再直接管理容器,而是作为一个高层管理器,通过 gRPC 接口与 containerd 通信。dockerd 处理用户命令(如 docker run)、镜像构建、网络/卷管理等,并将容器相关操作委托给 containerd。

Docker底层依赖 containerd ,如果不安装 containerd ,Docker 会启动失败,因为 dockerd 需要连接到 containerd.sock(由 containerd 服务生成)。这会导致整个链条崩溃:cri-dockerd → dockerd → containerd。

即使 Kubernetes 通过 cri-dockerd 使用 Docker,Docker 本身还是依赖 containerd 来实际执行容器操作。没有 containerd,cri-dockerd 和 Docker 都无法工作。

# 下载 containerd.service, 版本需要与 docker 二进制包中的 containerd 一致

# https://github.com/containerd/containerd/blob/main/containerd.service

wget https://raw.githubusercontent.com/containerd/containerd/refs/tags/v1.7.28/containerd.service

# containerd 路径修改后,内容如下:

cat >/etc/systemd/system/containerd.service <<EOF

[Unit]

Description=containerd container runtime

Documentation=https://containerd.io

After=network.target local-fs.target dbus.service

[Service]

ExecStartPre=-/sbin/modprobe overlay

ExecStart=/usr/bin/containerd

Type=notify

Delegate=yes

KillMode=process

Restart=always

RestartSec=5

LimitNPROC=infinity

LimitCORE=infinity

LimitNOFILE=infinity

TasksMax=infinity

OOMScoreAdjust=-999

[Install]

WantedBy=multi-user.target

EOF

# 设置 containerd 开机自启

systemctl enable --now containerd.service

# 将 containerd.service 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /etc/systemd/system/containerd.service $user@$i:/etc/systemd/system/;

done

# 配置设置每一台服务器 containerd 开机自启

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

for host in $hosts; do

ssh root@$host "systemctl enable --now containerd.service"

done

# 验证

systemctl is-enabled containerd.service命令解析:

[Unit] Description=containerd container runtime:指定服务的描述信息。 Documentation=https://containerd.io:指定服务的文档链接。 After=network.target local-fs.target:指定服务的启动顺序,在网络和本地文件系统启动之后再启动该服务。 [Service] ExecStartPre=-/sbin/modprobe overlay:在启动服务之前执行的命令,使用-表示忽略错误。 ExecStart=/usr/bin/containerd:指定服务的启动命令。 Type=notify:指定服务的类型,notify表示服务会在启动完成后向systemd发送通知。 Delegate=yes:允许服务代理其他服务的应答,例如收到关机命令后终止其他服务。 KillMode=process:指定服务终止时的行为,process表示终止服务进程。 Restart=always:指定服务终止后是否自动重启,always表示总是自动重启。 RestartSec=5:指定服务重启的时间间隔,单位为秒。 LimitNPROC=infinity:限制服务的最大进程数,infinity表示没有限制。 LimitCORE=infinity:限制服务的最大核心数,infinity表示没有限制。 LimitNOFILE=1048576:限制服务的最大文件数,指定为1048576。 TasksMax=infinity:限制服务的最大任务数,infinity表示没有限制。 OOMScoreAdjust=-999:指定服务的OOM(Out of Memory)得分,负数表示降低被终止的概率。 [Install] WantedBy=multi-user.target:指定服务的安装方式,multi-user.target表示该服务在多用户模式下安装。

18.3 配置 docker.service

下载地址:https://github.com/moby/moby/blob/master/contrib/init/systemd/docker.service

# 下载 docker.service

wget https://raw.githubusercontent.com/moby/moby/refs/tags/v28.4.0/contrib/init/systemd/docker.service

# 修改后写入到指定目录中

cat > /etc/systemd/system/docker.service <<EOF

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target nss-lookup.target docker.socket firewalld.service containerd.service time-set.target cri-docker.service

Wants=network-online.target containerd.service

Requires=docker.socket containerd.service

StartLimitBurst=3

StartLimitIntervalSec=60

[Service]

Type=notify

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

ExecReload=/bin/kill -s HUP $MAINPID

TimeoutStartSec=0

RestartSec=2

Restart=always

LimitNPROC=infinity

LimitCORE=infinity

TasksMax=infinity

Delegate=yes

KillMode=process

OOMScoreAdjust=-500

[Install]

WantedBy=multi-user.target

EOF

# 将 docker.service 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /etc/systemd/system/docker.service $user@$i:/etc/systemd/system/;

done命令解析:

[Unit] Description: 描述服务的作用,这里是Docker Application Container Engine,即Docker应用容器引擎。 Documentation: 提供关于此服务的文档链接,这里是Docker官方文档链接。 After: 说明该服务在哪些其他服务之后启动,这里是在网络在线、firewalld服务和containerd服务后启动。 Wants: 说明该服务想要的其他服务,这里是网络在线服务。 Requires: 说明该服务需要的其他服务,这里是docker.socket和containerd.service。 [Service] Type: 服务类型,这里是notify,表示服务在启动完成时发送通知。 ExecStart: 命令,启动该服务时会执行的命令,这里是/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock,即启动dockerd并指定一些参数,其中-H指定dockerd的监听地址为fd://,--containerd指定containerd的sock文件位置。 ExecReload: 重载命令,当接收到HUP信号时执行的命令,这里是/bin/kill -s HUP $MAINPID,即发送HUP信号给主进程ID。 TimeoutSec: 服务超时时间,这里是0,表示没有超时限制。 RestartSec: 重启间隔时间,这里是2秒,表示重启失败后等待2秒再重启。 Restart: 重启策略,这里是always,表示总是重启。 StartLimitBurst: 启动限制次数,这里是3,表示在启动失败后最多重试3次。 StartLimitInterval: 启动限制时间间隔,这里是60秒,表示两次启动之间最少间隔60秒。 LimitNOFILE: 文件描述符限制,这里是infinity,表示没有限制。 LimitNPROC: 进程数限制,这里是infinity,表示没有限制。 LimitCORE: 核心转储限制,这里是infinity,表示没有限制。 TasksMax: 最大任务数,这里是infinity,表示没有限制。 Delegate: 修改权限,这里是yes,表示启用权限修改。 KillMode: 杀死模式,这里是process,表示杀死整个进程组。 OOMScoreAdjust: 用于调整进程在系统内存紧张时的优先级调整,这里是-500,表示将OOM分数降低500。 [Install] WantedBy: 安装目标,这里是multi-user.target,表示在多用户模式下安装。 在WantedBy参数中,我们可以使用以下参数: multi-user.target:指定该服务应该在多用户模式下启动。 graphical.target:指定该服务应该在图形化界面模式下启动。 default.target:指定该服务应该在系统的默认目标(runlevel)下启动。 rescue.target:指定该服务应该在系统救援模式下启动。 poweroff.target:指定该服务应该在关机时启动。 reboot.target:指定该服务应该在重启时启动。 halt.target:指定该服务应该在停止时启动。 shutdown.target:指定该服务应该在系统关闭时启动。 这些参数可以根据需要选择一个或多个,以告知系统在何时启动该服务。

18.4 准备 docker 的 socket 文件

下载地址:https://github.com/moby/moby/blob/v28.4.0/contrib/init/systemd/docker.socket

# 下载 docker.socket

wget https://raw.githubusercontent.com/moby/moby/refs/tags/v28.4.0/contrib/init/systemd/docker.socket

# 修改后写入到指定路径

cat > /etc/systemd/system/docker.socket <<EOF

[Unit]

Description=Docker Socket for the API

[Socket]

# If /var/run is not implemented as a symlink to /run, you may need to

# specify ListenStream=/var/run/docker.sock instead.

ListenStream=/var/run/docker.sock

SocketMode=0660

SocketUser=root

SocketGroup=docker

[Install]

WantedBy=sockets.target

EOF

# 将 docker.socket 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /etc/systemd/system/docker.socket $user@$i:/etc/systemd/system/;

done命令解析:

这是一个用于Docker API的socket配置文件,包含了以下参数: [Unit] Description:描述了该socket的作用,即为Docker API的socket。 [Socket] ListenStream:指定了 socket 的监听地址,该 socket 会监听在 /var/run/docker.sock 上,即 Docker 守护程序使用的默认 sock 文件。 SocketMode:指定了socket文件的权限模式,此处为0660,即用户和用户组有读写权限,其他用户无权限。 SocketUser:指定了socket文件的所有者,此处为root用户。 SocketGroup:指定了socket文件的所属用户组,此处为docker用户组。 [Install] WantedBy:指定了该socket被启用时的目标,此处为sockets.target,表示当sockets.target启动时启用该socket。 该配置文件的作用是为 Docker 提供 API 访问的通道,它监听在 /var/run/docker.sock 上,具有 root 用户权限,但只接受 docker 用户组的成员的连接,并且其他用户无法访问。这样,只有 docker 用户组的成员可以通过该 socket 与 Docker 守护进程进行通信。

18.5 配置 Docker 加速器

# 创建 docker 配置目录 和 数据目录

mkdir /etc/docker/ /data/docker -pv

# 写入docker配置,这里也修改了docker默认的数据目录

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"registry-mirrors": [

"https://kfp63jaj.mirror.aliyuncs.com",

"https://hub-mirror.c.163.com",

"https://mirror.baidubce.com"

],

"max-concurrent-downloads": 10,

"log-driver": "json-file",

"log-level": "warn",

"log-opts": {

"max-size": "10m",

"max-file": "3"

},

"data-root": "/data/docker"

}

EOF

# 配置设置每一台服务器都创建docker的配置目录和数据目录

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

for host in $hosts; do

ssh root@$host "mkdir /etc/docker/ /data/docker -pv"

done

# 将 daemon.json 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /etc/docker/daemon.json $user@$i:/etc/docker/;

done命令解析:

该参数文件中包含以下参数: exec-opts: 用于设置Docker守护进程的选项,native.cgroupdriver=systemd表示使用systemd作为Cgroup驱动程序。 registry-mirrors: 用于指定Docker镜像的镜像注册服务器。在这里有三个镜像注册服务器:https://docker.m.daocloud.io、https://docker.mirrors.ustc.edu.cn和http://hub-mirror.c.163.com。 max-concurrent-downloads: 用于设置同时下载镜像的最大数量,默认值为3,这里设置为10。 log-driver: 用于设置Docker守护进程的日志驱动程序,这里设置为json-file。 log-level: 用于设置日志的级别,这里设置为warn。 log-opts: 用于设置日志驱动程序的选项,这里有两个选项:max-size和max-file。max-size表示每个日志文件的最大大小,这里设置为10m,max-file表示保存的最大日志文件数量,这里设置为3。 data-root: 用于设置Docker守护进程的数据存储根目录,默认为/var/lib/docker,这里设置为 /data/docker。

18.6 启动 Docker

# 创建一个名为 docker 的组

groupadd docker

# 通知systemd重新加载所有单元配置文件(unit files),以识别新创建或修改的配置文件

systemctl daemon-reload

# 启用并立即启动Docker的socket单元(docker.socket),使其在系统启动时自动运行,并现在开始监听。

systemctl enable --now docker.socket

# 启用并立即启动Docker守护进程服务(docker.service),使其在系统启动时自动运行,并现在开始运行。

systemctl enable --now docker.service

# 重启docker.socket单元

systemctl restart --now docker.socket

# 重启docker.service单元,即重新启动Docker守护进程。

systemctl restart docker.service

# 验证:查看 docker 服务状态

systemctl status docker.service

# 验证:查看docker信息

docker info

# 集群中的其他服务器也启动 Docker

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

for host in $hosts; do

ssh root@$host "groupadd docker"

ssh root@$host "systemctl daemon-reload"

ssh root@$host "systemctl enable --now docker.socket"

ssh root@$host "systemctl enable --now docker.service"

ssh root@$host "systemctl restart --now docker.socket"

ssh root@$host "systemctl restart docker.service"

done19. 安装 cri-docker

19.1 安装 cri-docker 二进制包

cri-docker 与 docker的版本匹配关系:https://github.com/Mirantis/cri-dockerd/releases/tag/v0.4.0

# 下载 cri-docker 二进制包

wget https://github.com/Mirantis/cri-dockerd/releases/download/v0.4.0/cri-dockerd-0.4.0.amd64.tgz

# 解压

tar xvf cri-dockerd-*.amd64.tgz

# 复制到 /usr/bin/

cp cri-dockerd/cri-dockerd /usr/bin/

# 授权

chmod +x /usr/bin/cri-dockerd

# 将 cri-dockerd 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/bin/cri-dockerd $user@$i:/usr/bin/;

done

# 验证

$ cri-dockerd --version

cri-dockerd 0.4.0 (b9b8893)19.2 配置 cri-docker.service

从 github 获取文件:https://github.com/Mirantis/cri-dockerd/tree/master/packaging/systemd

# 下载 cri-docker.service 文件

wget https://raw.githubusercontent.com/Mirantis/cri-dockerd/refs/tags/v0.4.0/packaging/systemd/cri-docker.service

# 修改 ExecStart 启动命令后,写入到指定目录

cat > /usr/lib/systemd/system/cri-docker.service <<EOF

[Unit]

Description=CRI Interface for Docker Application Container Engine

Documentation=https://docs.mirantis.com

After=network-online.target firewalld.service docker.service

Wants=network-online.target

Requires=cri-docker.socket

[Service]

Type=notify

# 修啊该启动命令

ExecStart=/usr/bin/cri-dockerd --pod-infra-container-image=registry.aliyuncs.com/google_containers/pause:3.9 --container-runtime-endpoint=unix:///var/run/cri-dockerd.sock --cri-dockerd-root-directory=/data/dockershim --cri-dockerd-root-directory=/data/docker

ExecReload=/bin/kill -s HUP $MAINPID

TimeoutSec=0

RestartSec=2

Restart=always

StartLimitBurst=3

StartLimitInterval=60s

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TasksMax=infinity

Delegate=yes

KillMode=process

[Install]

WantedBy=multi-user.target

EOF

# 将 cri-docker.service 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/lib/systemd/system/cri-docker.service $user@$i:/usr/lib/systemd/system/;

done命令解析:

[Unit] Description:该参数用于描述该单元的功能,这里描述的是CRI与Docker应用容器引擎的接口。 Documentation:该参数指定了相关文档的网址,供用户参考。 After:该参数指定了此单元应该在哪些其他单元之后启动,确保在网络在线、防火墙和Docker服务启动之后再启动此单元。 Wants:该参数指定了此单元希望也启动的所有单元,此处是希望在网络在线之后启动。 Requires:该参数指定了此单元需要依赖的单元,此处是cri-docker.socket单元。 [Service] Type:该参数指定了服务的类型,这里是notify,表示当服务启动完成时向系统发送通知。 ExecStart:该参数指定了将要运行的命令和参数,此处是执行/usr/bin/cri-dockerd 命令,并指定了网络插件为cni和Pod基础设施容器的镜像为registry.aliyuncs.com/google_containers/pause:3.9。 - --container-runtime-endpoint=unix:///var/run/cri-dockerd.sock - 定义 CRI 的监听端点。 - --cri-dockerd-root-directory=/data/dockershim - 定义 cri-dockerd 的根目录,用于存储临时文件或配置数据。 - --cri-dockerd-root-directory=/data/docker - 定义 Docker 的根目录。 ExecReload:该参数指定在服务重载时运行的命令,此处是发送HUP信号给主进程。 TimeoutSec:该参数指定了服务启动的超时时间,此处为0,表示无限制。 RestartSec:该参数指定了自动重启服务的时间间隔,此处为2秒。 Restart:该参数指定了在服务发生错误时自动重启,此处是始终重启。 StartLimitBurst:该参数指定了在给定时间间隔内允许的启动失败次数,此处为3次。 StartLimitInterval:该参数指定启动失败的时间间隔,此处为60秒。 LimitNOFILE:该参数指定了允许打开文件的最大数量,此处为无限制。 LimitNPROC:该参数指定了允许同时运行的最大进程数,此处为无限制。 LimitCORE:该参数指定了允许生成的core文件的最大大小,此处为无限制。 TasksMax:该参数指定了此服务的最大任务数,此处为无限制。 Delegate:该参数指定了是否将控制权委托给指定服务,此处为是。 KillMode:该参数指定了在终止服务时如何处理进程,此处是通过终止进程来终止服务。 [Install] WantedBy:该参数指定了希望这个单元启动的多用户目标。在这里,这个单元希望在multi-user.target启动。

19.3 配置 cri-docker.socket

从 github 获取文件:https://github.com/Mirantis/cri-dockerd/tree/master/packaging/systemd

# 下载

wget https://raw.githubusercontent.com/Mirantis/cri-dockerd/refs/tags/v0.4.0/packaging/systemd/cri-docker.socket

# 修改 ListenStream,并写入到指令目录

cat > /usr/lib/systemd/system/cri-docker.socket <<EOF

[Unit]

Description=CRI Docker Socket for the API

PartOf=cri-docker.service

[Socket]

ListenStream=/var/run/cri-dockerd.sock

SocketMode=0660

SocketUser=root

SocketGroup=docker

[Install]

WantedBy=sockets.target

EOF

# 将 cri-docker.socket 复制到其它服务器中

hots='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/lib/systemd/system/cri-docker.socket $user@$i:/usr/lib/systemd/system/;

done命令解析:

该配置文件是用于systemd的单元配置文件(unit file),用于定义一个socket单元。 [Unit] Description:表示该单元的描述信息。 PartOf:表示该单元是cri-docker.service的一部分。 [Socket] ListenStream:指定了该socket要监听的地址和端口,这里要与 cri-docker.service 配置的 ExecStart 指定的套接字一致,都为 /var/run/cri-dockerd.sock。Unix域套接字用于在同一台主机上的进程之间通信。 SocketMode:指定了socket文件的权限模式,此处为0660,即用户和用户组有读写权限,其他用户无权限。 SocketUser:指定了socket文件的所有者,此处为root用户。 SocketGroup:指定了socket文件的所属用户组,此处为docker用户组。 [Install] WantedBy:部分定义了该单元的安装配置信息。WantedBy=sockets.target表示当sockets.target单元启动时,自动启动该socket单元。sockets.target是一个系统服务,用于管理所有的socket单元。

19.4 启动 cri-docker

# 通知systemd重新加载所有单元配置文件(unit files),以识别新创建或修改的配置文件

systemctl daemon-reload

# 设置开机自启

systemctl enable --now cri-docker.service

systemctl enable --now cri-docker.socket

# 重启cri-docker.service单元,即重新启动cri-docker守护进程。

systemctl restart cri-docker.service

# 验证,查看状态

systemctl status cri-docker.service

# 集群中的其他服务器也启动 Docker

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

for host in $hosts; do

ssh root@$host "systemctl daemon-reload"

ssh root@$host "systemctl enable --now cri-docker.service"

ssh root@$host "systemctl enable --now cri-docker.socket"

done四、K8S 与 ETCD 下载及安装(在 master01 节点上操作)

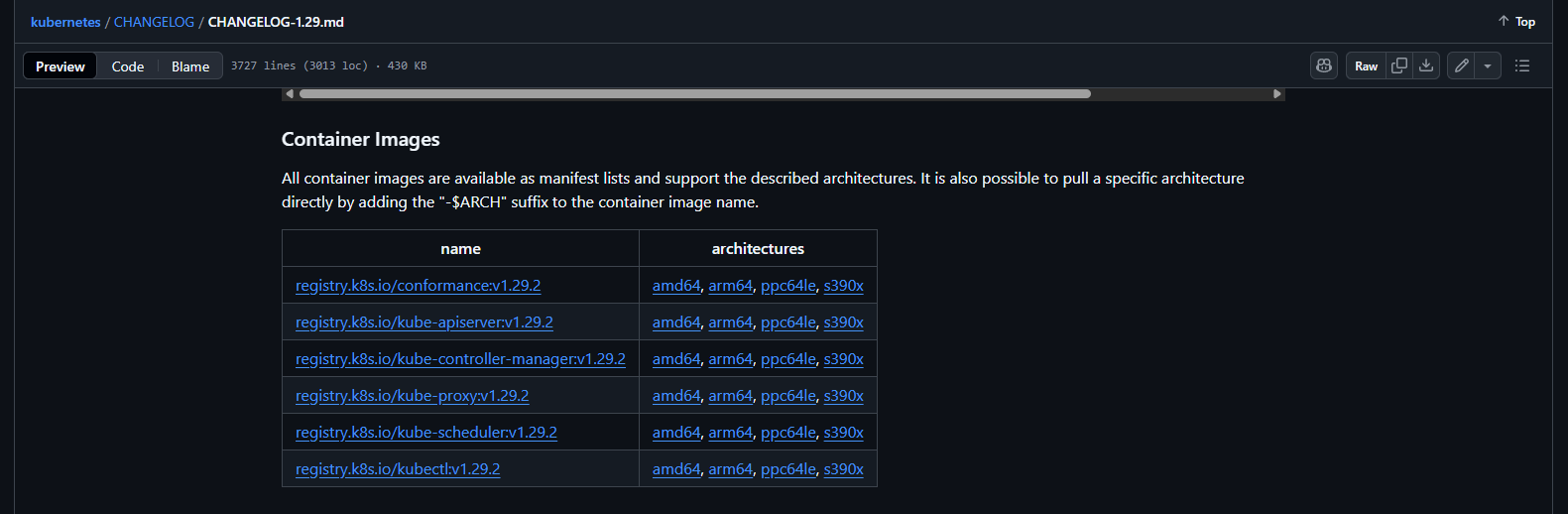

当前选择安装 K8S 版本:1.29.2,ETCD 版本:3.5.16

查看 K8S 与 ETCD 的版本匹配关系以及二进制包下载地址

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG/CHANGELOG-1.29.md

https://github.com/kubernetes/kubernetes/blob/release-1.29/cluster/images/etcd/Makefile

需要下载的镜像

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG/CHANGELOG-1.29.md#container-images-13

1. 安装 K8S 二进制包

下载地址:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG/CHANGELOG-1.29.md#v1292

# 下载 K8S 二进制包

wget https://dl.k8s.io/v1.29.2/kubernetes-server-linux-amd64.tar.gz

# 解压文件到指定目录

tar -xf kubernetes-server-linux-amd64.tar.gz --strip-components=3 -C /usr/local/bin kubernetes/server/bin/kube{let,ctl,-apiserver,-controller-manager,-scheduler,-proxy}

# 查看解压的文件

$ ls /usr/local/bin/

kube-apiserver kube-controller-manager kube-proxy kube-scheduler kubectl kubelet

# 将解压后的 K8S 二进制包复制到其它服务器中

# 拷贝 master 组件

hots='k8s-master02 k8s-master03'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/local/bin/kube* $user@$i:/usr/local/bin/;

done

# 拷贝 worker 组件

hots='k8s-node01 k8s-node02'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/local/bin/kube{let,-proxy} $user@$i:/usr/local/bin/;

done

# 验证

$ kubelet --version

Kubernetes v1.29.2命令解析:

这是一个 tar 命令,用于解压指定的 kubernetes-server-linux-amd64.tar.gz 文件,并将其中的特定文件提取到 /usr/local/bin 目录下。 命令的解释如下: tar:用于处理 tar 压缩文件的命令。 -xf:表示解压操作。 kubernetes-server-linux-amd64.tar.gz:要解压的文件名。 --strip-components=3:表示解压时忽略压缩文件中的前3级目录结构,提取文件时直接放到目标目录中。 -C /usr/local/bin:指定提取文件的目标目录为 /usr/local/bin。 kubernetes/server/bin/kube{let,ctl,-apiserver,-controller-manager,-scheduler,-proxy}:要解压和提取的文件名模式,用花括号括起来表示模式中的多个可能的文件名。 总的来说,这个命令的作用是将 kubernetes-server-linux-amd64.tar.gz 文件中的 kubelet、kubectl、kube-apiserver、kube-controller-manager、kube-scheduler和kube-proxy 六个文件提取到 /usr/local/bin 目录下,同时忽略文件路径中的前三级目录结构。

2. 安装 ETCD 二进制包

下载地址:https://github.com/etcd-io/etcd/releases/tag/v3.5.16

# 下载 ETCD 二进制安装包

wget https://github.com/etcd-io/etcd/releases/download/v3.5.16/etcd-v3.5.16-linux-amd64.tar.gz

# 解压etcd安装文件

tar -xf etcd*.tar.gz && mv etcd-*/etcd /usr/local/bin/ && mv etcd-*/etcdctl /usr/local/bin/

# 将解压后的 K8S 二进制包复制到其它服务器中

hots='k8s-master02 k8s-master03'

user=root

for i in $hots; do

echo $i;

rsync --rsync-path="sudo rsync" /usr/local/bin/etcd* $user@$i:/usr/local/bin/;

done

# 验证:查看/usr/local/bin下内容

$ etcdctl version

etcdctl version: 3.5.16

API version: 3.53. 生成相关证书

3.1 安装证书工具

k8s-master01

# master01 节点下载证书生成工具

wget https://github.com/cloudflare/cfssl/releases/download/v1.6.4/cfssl_1.6.4_linux_amd64 -O /usr/local/bin/cfssl

wget https://github.com/cloudflare/cfssl/releases/download/v1.6.4/cfssljson_1.6.4_linux_amd64 -O /usr/local/bin/cfssljson

chmod +x /usr/local/bin/cfssl /usr/local/bin/cfssljson3.2 生成 ETCD 证书

3.2.1 ca-config.json

k8s-master01

# 创建目录,存放生成的证书

mkdir /etc/etcd/ssl -p

# 写入生成证书所需的配置文件,master01 节点生成 etcd 证书

cat > /etc/etcd/ssl/ca-config.json << EOF

{

"signing": {

"default": {

"expiry": "876000h"

},

"profiles": {

"kubernetes": {

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

],

"expiry": "876000h"

}

}

}

}

EOF命令解析:

ca-config.json文件是使用CFSSL(CloudFlare’s PKI/TLS toolkit)工具生成证书的核心配置文件。它主要用于定义证书签名的全局策略和配置文件(profiles),确保生成的证书具有一致的安全属性、用途和有效期。在这里,有两个部分:signing 和 profiles。 signing 包含了默认签名配置和配置文件。 默认签名配置 default 指定了证书的过期时间为 876000h 。876000h 表示证书有效期为 100 年。 profiles 部分定义了不同的证书配置文件。 在这里,只有一个配置文件 kubernetes 。它包含了以下 usages 和过期时间 expiry: signing:用于对其他证书进行签名 key encipherment:用于加密和解密传输数据 server auth:用于服务器身份验证 client auth:用于客户端身份验证 对于 kubernetes 配置文件,证书的过期时间也是 876000h,即100年。

3.2.2 etcd-ca-csr.json

k8s-master01

cat > /etc/etcd/ssl/etcd-ca-csr.json << EOF

{

"CN": "etcd",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "etcd",

"OU": "Etcd Security"

}

],

"ca": {

"expiry": "876000h"

}

}

EOF命令解析:

etcd-ca-csr.json 是 Certificate Signing Request (CSR) 文件,用于生成 ETCD 的根 CA 证书(etcd-ca.pem 和 etcd-ca-key.pem)。根 CA 证书是 ETCD 集群的安全基石,用于签署 ETCD 节点证书(etcd.pem 和 etcd-key.pem)和其他相关证书,确保集群内部通信的加密和身份验证。

JSON 配置文件指定了生成证书签名请求所需的数据。 "CN": "etcd" 指定了希望生成的证书的 CN 字段(Common Name),即证书的主题,通常是该证书标识的实体的名称。 "key": {} 指定了生成证书所使用的密钥的配置信息。"algo": "rsa" 指定了密钥的算法为 RSA,"size": 2048 指定了密钥的长度为 2048 位。 "names": [] 包含了生成证书时所需的实体信息。在这个例子中,只包含了一个实体,其相关信息如下: "C": "CN" 指定了实体的国家/地区代码,这里是中国。 "ST": "Beijing" 指定了实体所在的省/州。 "L": "Beijing" 指定了实体所在的城市。 "O": "etcd" 指定了实体的组织名称。 "OU": "Etcd Security" 指定了实体所属的组织单位。 "ca": {} 指定了生成证书时所需的CA(Certificate Authority)配置信息。 "expiry": "876000h" 指定了证书的有效期,这里是876000小时。 生成证书签名请求时,可以使用这个 JSON 配置文件作为输入,根据配置文件中的信息生成相应的 CSR 文件。然后,可以将 CSR 文件发送给 CA 进行签名,以获得有效的证书。 生成 etcd 证书和 etcd 证书的 key(如果你觉得以后可能会扩容,可以在 ip 那多写几个预留出来) 若没有IPv6 可删除可保留

3.2.3 生成 ETCD 的根 CA 证书

k8s-master01

# 生成 ETCD 的根 CA 证书

cfssl gencert -initca /etc/etcd/ssl/etcd-ca-csr.json | cfssljson -bare /etc/etcd/ssl/etcd-ca

# 查看生成的 ETCD 的根 CA 证书

$ ll /etc/etcd/ssl/

total 20

-rw-r--r--. 1 root root 294 Oct 11 19:03 ca-config.json

-rw-r--r--. 1 root root 249 Oct 11 19:20 etcd-ca-csr.json

-rw-------. 1 root root 1679 Oct 11 19:21 etcd-ca-key.pem

-rw-r--r--. 1 root root 1050 Oct 11 19:21 etcd-ca.csr

-rw-r--r--. 1 root root 1318 Oct 11 19:21 etcd-ca.pem具体的解释如下: cfssl 是一个用于生成 TLS/SSL 证书的工具,它支持 PKI、JSON 格式配置文件以及与许多其他集成工具的配合使用。 gencert 参数表示生成证书的操作。-initca 参数表示初始化一个CA(证书颁发机构)。CA 是用于签发其他证书的根证书。etcd-ca-csr.json 是一个 JSON 格式的配置文件,其中包含了CA的详细信息,如私钥、公钥、有效期等。这个文件提供了生成 CA 证书所需的信息。 | 符号表示将上一个命令的输出作为下一个命令的输入。 cfssljson 是 cfssl 工具的一个子命令,用于格式化 cfssl 生成的 JSON 数据。 -bare 参数表示直接输出裸证书,即只生成证书文件,不包含其他格式的文件。/etc/etcd/ssl/etcd-ca 是指定生成的证书文件的路径和名称。 所以,这条命令的含义是使用 cfssl 工具根据配置文件 etcd-ca-csr.json 生成一个 CA 证书,并将证书文件保存在 /etc/etcd/ssl/etcd-ca 路径下。

3.2.4 etcd-csr.json

k8s-master01

cat > /etc/etcd/ssl/etcd-csr.json << EOF

{

"CN": "etcd",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "etcd",

"OU": "Etcd Security"

}

]

}

EOF命令解析:

etcd-csr.json 用于生成 ETCD 节点的 TLS 证书(etcd.pem 和 etcd-key.pem),这些证书由 ETCD 的根 CA(通过 etcd-ca-csr.json 生成的 etcd-ca.pem)签署。

这段代码是一个 JSON 格式的配置文件,用于生成一个证书签名请求(Certificate Signing Request,CSR)。 首先,"CN"字段指定了该证书的通用名称(Common Name),这里设为"etcd"。 接下来,"key"字段指定了密钥的算法("algo"字段)和长度("size"字段),此处使用的是RSA算法,密钥长度为2048位。 最后,"names"字段是一个数组,其中包含了一个名字对象,用于指定证书中的一些其他信息。这个名字对象包含了以下字段: "C"字段指定了国家代码(Country),这里设置为"CN"。 "ST"字段指定了省份(State)或地区,这里设置为"Beijing"。 "L"字段指定了城市(Locality),这里设置为"Beijing"。 "O"字段指定了组织(Organization),这里设置为"etcd"。 "OU"字段指定了组织单元(Organizational Unit),这里设置为"Etcd Security"。 这些字段将作为证书的一部分,用于标识和验证证书的使用范围和颁发者等信息。

3.2.5 生成 ETCD 节点证书

k8s-master01

# 生成 ETCD 节点证书

cfssl gencert \

-ca=/etc/etcd/ssl/etcd-ca.pem \

-ca-key=/etc/etcd/ssl/etcd-ca-key.pem \

-config=/etc/etcd/ssl/ca-config.json \

-hostname=127.0.0.1,k8s-master01,k8s-master02,k8s-master03,10.20.1.101,10.20.1.102,10.20.1.103,2400:3200::101,2400:3200::102,2400:3200::103,::1 \

-profile=kubernetes \

/etc/etcd/ssl/etcd-csr.json | cfssljson -bare /etc/etcd/ssl/etcd命令解析:

这是一条使用cfssl生成etcd节点证书的命令,下面是各个参数的解释: -ca=/etc/etcd/ssl/etcd-ca.pem:指定用于签名etcd证书的CA文件的路径。 -ca-key=/etc/etcd/ssl/etcd-ca-key.pem:指定用于签名etcd证书的CA私钥文件的路径。 -config=ca-config.json:指定CA配置文件的路径,该文件定义了证书的有效期、加密算法等设置。 -hostname=xxxx:指定要为etcd生成证书的主机名和IP地址列表。 -profile=kubernetes:指定使用的证书配置文件,该文件定义了证书的用途和扩展属性。 etcd-csr.json:指定etcd证书请求的JSON文件的路径,该文件包含了证书请求的详细信息。 | cfssljson -bare /etc/etcd/ssl/etcd:通过管道将cfssl命令的输出传递给cfssljson命令,并使用-bare参数指定输出文件的前缀路径,这里将生成etcd证书的.pem和-key.pem文件。 这条命令的作用是使用指定的CA证书和私钥,根据证书请求的JSON文件和配置文件生成etcd的证书文件。

3.2.6 将证书复制到其他节点

k8s-master01

# 将生成的 ETCD 证书复制到其他节点

hosts='k8s-master02 k8s-master03'

for host in $hosts; do

echo $host;

ssh root@$host "mkdir /etc/etcd/ssl -p"

rsync --rsync-path="sudo rsync" /etc/etcd/ssl/* $user@$host:/etc/etcd/ssl/;

done3.3 生成 K8S 相关证书

3.3.1 ca-config.json

k8s-master01

# 创建目录,用于存放 K8S 相关证书

mkdir -p /etc/kubernetes/pki

cat > /etc/kubernetes/pki/ca-config.json << EOF

{

"signing": {

"default": {

"expiry": "876000h"

},

"profiles": {

"kubernetes": {

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

],

"expiry": "876000h"

}

}

}

}

EOF命令解析:

ca-config.json文件是使用CFSSL(CloudFlare’s PKI/TLS toolkit)工具生成证书的核心配置文件。它主要用于定义证书签名的全局策略和配置文件(profiles),确保生成的证书具有一致的安全属性、用途和有效期。在这里,有两个部分:signing 和 profiles。 signing 包含了默认签名配置和配置文件。 默认签名配置 default 指定了证书的过期时间为 876000h 。876000h 表示证书有效期为 100 年。 profiles 部分定义了不同的证书配置文件。 在这里,只有一个配置文件 kubernetes 。它包含了以下 usages 和过期时间 expiry: signing:用于对其他证书进行签名 key encipherment:用于加密和解密传输数据 server auth:用于服务器身份验证 client auth:用于客户端身份验证 对于 kubernetes 配置文件,证书的过期时间也是 876000h,即100年。

3.3.2 ca-csr.json

cat > /etc/kubernetes/pki/ca-csr.json << EOF

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Guangdong",

"L": "Guangzhou",

"O": "Kubernetes",

"OU": "System"

}

],

"ca": {

"expiry": "876000h"

}

}

EOF命令解析:

ca-csr.json 用于生成 Kubernetes 集群的根 CA 证书(ca.pem 和 ca-key.pem)。根 CA 证书是 Kubernetes 安全体系的核心,用于签署集群内所有组件的证书(如 API Server、kubelet、admin 用户等),支持 TLS 加密和 Mutual TLS 认证。

这是一个用于生成 Kubernetes 相关证书的配置文件。该配置文件中包含以下信息: CN:CommonName,即用于标识证书的通用名称。在此配置中,CN 设置为 "kubernetes",表示该证书是用于 Kubernetes。 key:用于生成证书的算法和大小。在此配置中,使用的算法是 RSA,大小是 2048 位。 names:用于证书中的名称字段的详细信息。在此配置中,有以下字段信息: C:Country,即国家。在此配置中,设置为 "CN"。 ST:State,即省/州。在此配置中,设置为 "Beijing"。 L:Locality,即城市。在此配置中,设置为 "Beijing"。 O:Organization,即组织。在此配置中,设置为 "Kubernetes"。 OU:Organization Unit,即组织单位。在此配置中,设置为 "Kubernetes-manual"。 ca:用于证书签名的证书颁发机构(CA)的配置信息。在此配置中,设置了证书的有效期为 876000 小时。 这个配置文件可以用于生成 Kubernetes 相关的证书,以确保集群中的通信安全性。

3.3.3 生成 Kubernetes 集群的根 CA 证书

cfssl gencert -initca /etc/kubernetes/pki/ca-csr.json | cfssljson -bare /etc/kubernetes/pki/ca命令解析:

具体的解释如下: cfssl是一个用于生成TLS/SSL证书的工具,它支持PKI、JSON格式配置文件以及与许多其他集成工具的配合使用。 gencert参数表示生成证书的操作。-initca参数表示初始化一个CA(证书颁发机构)。CA是用于签发其他证书的根证书。ca-csr.json是一个JSON格式的配置文件,其中包含了CA的详细信息,如私钥、公钥、有效期等。这个文件提供了生成CA证书所需的信息。 | 符号表示将上一个命令的输出作为下一个命令的输入。 cfssljson是cfssl工具的一个子命令,用于格式化cfssl生成的JSON数据。 -bare参数表示直接输出裸证书,即只生成证书文件,不包含其他格式的文件。/etc/kubernetes/pki/ca是指定生成的证书文件的路径和名称。 所以,这条命令的含义是使用cfssl工具根据配置文件ca-csr.json生成一个CA证书,并将证书文件保存在/etc/kubernetes/pki/ca路径下。

3.3.4 apiserver-csr.json

cat > /etc/kubernetes/pki/apiserver-csr.json << EOF

{

"CN": "kube-apiserver",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "Kubernetes",

"OU": "Kubernetes-manual"

}

]

}

EOF命令解析:

apiserver-csr.json 用于生成 Kubernetes API Server 的 TLS 证书(apiserver.pem 和 apiserver-key.pem),这些证书由 Kubernetes 的根 CA(通过 ca-csr.json 生成的 ca.pem)签署。

证书用于:

- 服务器端认证:确保 API Server 的身份可信,客户端(如 kubectl、kubelet)可以通过 CA 证书(ca.pem)验证 API Server。

- 客户端认证:支持 Mutual TLS,API Server 验证客户端证书(如 admin、kubelet)的合法性。

- 加密通信:通过 TLS 加密 API Server 与客户端之间的通信,防止数据泄露或篡改。

3.3.5 生成 apiserver 证书

cfssl gencert \

-ca=/etc/kubernetes/pki/ca.pem \

-ca-key=/etc/kubernetes/pki/ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-hostname=10.96.0.1,127.0.0.1,kubernetes,kubernetes.default,kubernetes.default.svc,kubernetes.default.svc.cluster,kubernetes.default.svc.cluster.local,10.20.1.101,10.20.1.102,10.20.1.103,10.20.1.104,10.20.1.105,10.20.1.106,10.20.1.107,10.20.1.108,10.20.1.109,2400:3200::101,2400:3200::102,2400:3200::103,2400:3200::104,2400:3200::105,2400:3200::106,2400:3200::107,2400:3200::108,2400:3200::109 \

-profile=kubernetes \

/etc/kubernetes/pki/apiserver-csr.json | cfssljson -bare /etc/kubernetes/pki/apiserver3.3.6 apiserver 聚合证书

访问 kube-apiserver 的另一种方式就是使用 kube-proxy 来代理访问, 而该证书就是用来支持 SSL 代理访问的。在该种访问模式下,我们是以http的方式发起请求到代理服务的, 此时, 代理服务会将该请求发送给 kube-apiserver , 在此之前, 代理会将发送给 kube-apiserver 的请求头里加入证书信息。

客户端 -- 发起请求 ---> 代理 -- Add Header信息:发起请求 --> kube-apiserve如果apiserver所在的主机上没有运行kube-proxy,既无法通过服务的ClusterIP进行访问,需要 --enable-aggregator-routing=true

3.3.6.1 front-proxy-ca-csr.json

cat > /etc/kubernetes/pki/front-proxy-ca-csr.json << EOF

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"ca": {

"expiry": "876000h"

}

}

EOF命令解析:

front-proxy-ca-csr.json 用于生成 Kubernetes 的 Front Proxy CA 证书(front-proxy-ca.pem 和 front-proxy-ca-key.pem)。Front Proxy CA 是 Kubernetes 集群中用于 前端代理认证 的独立 CA,专门用于签署前端代理客户端证书(如 front-proxy-client.pem),以支持 API Server 的请求头认证机制。

3.3.6.2 生成 Kubernetes Front Proxy 根 CA 证书

包括证书文件(front-proxy-ca.pem)、私钥文件(front-proxy-ca-key.pem)和 CSR 文件(front-proxy-ca.csr)

# 指示 CFSSL 生成根 CA 证书(而非普通证书)

cfssl gencert -initca /etc/kubernetes/pki/front-proxy-ca-csr.json | cfssljson -bare /etc/kubernetes/pki/front-proxy-ca

# 生成 前端代理客户端证书 的 CSR 配置文件

cat > /etc/kubernetes/pki/front-proxy-client-csr.json << EOF

{

"CN": "front-proxy-client",

"key": {

"algo": "rsa",

"size": 2048

}

}

EOF

# 生成前端代理客户端证书

cfssl gencert \

-ca=/etc/kubernetes/pki/front-proxy-ca.pem \

-ca-key=/etc/kubernetes/pki/front-proxy-ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-profile=kubernetes /etc/kubernetes/pki/front-proxy-client-csr.json | cfssljson -bare /etc/kubernetes/pki/front-proxy-client命令解析1:

cfssl gencert -initca front-proxy-ca-csr.json | cfssljson -bare /etc/kubernetes/pki/front-proxy-ca

这个命令使用 CFSSL 工具生成 Kubernetes Front Proxy CA 证书(根 CA 证书),包括证书文件(front-proxy-ca.pem)、私钥文件(front-proxy-ca-key.pem)和 CSR 文件(front-proxy-ca.csr)。

Front Proxy CA 的背景:在 Kubernetes 高可用集群中,Front Proxy CA 是用于 请求头认证(RequestHeader Authentication) 的独立 CA。它专门用于签署前端代理客户端证书(如 front-proxy-client.pem),以支持 API Server 的聚合层(Aggregation Layer)。这对于扩展组件(如 Metrics Server)至关重要,确保客户端(如 Metrics Server)可以通过 HTTP 请求头提供身份信息,并由 API Server 验证。

上下文:博客中,此证书用于 Metrics Server 的部署(components.yaml 中引用 –requestheader-client-ca-file=/etc/kubernetes/pki/front-proxy-ca.pem),确保高可用集群(3 Master 节点 + 2 Node 节点)的扩展 API 安全。

命令解析2:

cat > front-proxy-client-csr.json << EOF … EOF

生成 前端代理客户端证书 的 CSR 配置文件

前端代理客户端证书的作用:用于 Metrics Server 或其他聚合 API 客户端的身份认证。客户端证书(front-proxy-client.pem 和 front-proxy-client-key.pem)由 Front Proxy CA 签署,API Server 使用它验证请求头中的客户端身份,确保只有可信客户端可以访问聚合 API

为什么需要?Kubernetes 的聚合层要求客户端提供证书以通过 RequestHeader 认证。Metrics Server 配置中引用了这些证书,确保安全访问 API Server。

上下文:博客中,此证书用于 Metrics Server 的 TLS 通信,支持高可用集群的扩展功能。

命令解析3:

cfssl gencert

-ca=/etc/kubernetes/pki/front-proxy-ca.pem

-ca-key=/etc/kubernetes/pki/front-proxy-ca-key.pem

-config=/etc/kubernetes/pki/ca-config.json

-profile=kubernetes /etc/kubernetes/pki/front-proxy-client-csr.json | cfssljson -bare /etc/kubernetes/pki/front-proxy-client

- 使用 CFSSL 生成 前端代理客户端证书(front-proxy-client.pem 和 front-proxy-client-key.pem),由 Front Proxy CA 签署。

- 客户端证书的作用:Metrics Server 等聚合客户端使用此证书在请求头中证明身份,API Server 通过 Front Proxy CA 验证,确保安全访问聚合 API(如 /apis/metrics.k8s.io/)

- Metrics Server 的配置(–requestheader-username-headers 等)依赖此证书,支持 RequestHeader 认证。

- 在高可用集群中,此证书分发到所有 Master 节点,供 kube-apiserver 使用

3.3.7 生成 controller-manage 的证书

# 生成 Kubernetes Controller Manager 客户端证书 的 Certificate Signing Request (CSR) 配置文件

cat > /etc/kubernetes/pki/manager-csr.json << EOF

{

"CN": "system:kube-controller-manager",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "system:kube-controller-manager",

"OU": "Kubernetes-manual"

}

]

}

EOF

# 使用 CFSSL 生成 Controller Manager 客户端证书(controller-manager.pem 和 controller-manager-key.pem),由 Kubernetes 根 CA(ca.pem)签署

cfssl gencert \

-ca=/etc/kubernetes/pki/ca.pem \

-ca-key=/etc/kubernetes/pki/ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-profile=kubernetes \

/etc/kubernetes/pki/manager-csr.json | cfssljson -bare /etc/kubernetes/pki/controller-manager

# 配置 Controller Manager 的 kubeconfig 文件(/etc/kubernetes/controller-manager.kubeconfig),定义集群信息,指定 API Server 的地址和 CA 证书。

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/kubernetes/pki/ca.pem \

--embed-certs=true \

--server=https://127.0.0.1:8443 \

--kubeconfig=/etc/kubernetes/controller-manager.kubeconfig

# 设置 kubeconfig 的上下文,将集群、用户和命名空间绑定,定义 Controller Manager 的访问环境

kubectl config set-context system:kube-controller-manager@kubernetes \

--cluster=kubernetes \

--user=system:kube-controller-manager \

--kubeconfig=/etc/kubernetes/controller-manager.kubeconfig

# 设置 Controller Manager 的用户凭据,指定其客户端证书和私钥,用于与 API Server 的身份认证

kubectl config set-credentials system:kube-controller-manager \

--client-certificate=/etc/kubernetes/pki/controller-manager.pem \

--client-key=/etc/kubernetes/pki/controller-manager-key.pem \

--embed-certs=true \

--kubeconfig=/etc/kubernetes/controller-manager.kubeconfig

# 设置 kubeconfig 文件的默认上下文,确保 Controller Manager 使用 system:kube-controller-manager@kubernetes 上下文访问 API Server

kubectl config use-context system:kube-controller-manager@kubernetes \

--kubeconfig=/etc/kubernetes/controller-manager.kubeconfig3.3.8 生成 kube-scheduler 的证书

# 生成 Kubernetes Scheduler 客户端证书 的 Certificate Signing Request (CSR) 配置文件

cat > /etc/kubernetes/pki/scheduler-csr.json << EOF

{

"CN": "system:kube-scheduler",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "system:kube-scheduler",

"OU": "Kubernetes-manual"

}

]

}

EOF

# 使用 CFSSL 生成 Scheduler 客户端证书(scheduler.pem 和 scheduler-key.pem),由 Kubernetes 根 CA(ca.pem)签署

cfssl gencert \

-ca=/etc/kubernetes/pki/ca.pem \

-ca-key=/etc/kubernetes/pki/ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-profile=kubernetes \

/etc/kubernetes/pki/scheduler-csr.json | cfssljson -bare /etc/kubernetes/pki/scheduler

# 配置 Scheduler 的 kubeconfig 文件(/etc/kubernetes/scheduler.kubeconfig),定义集群信息,指定 API Server 的地址和 CA 证书。

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/kubernetes/pki/ca.pem \

--embed-certs=true \

--server=https://127.0.0.1:8443 \

--kubeconfig=/etc/kubernetes/scheduler.kubeconfig

# 设置 Scheduler 的用户凭据,指定其客户端证书和私钥,用于与 API Server 的身份认证。

kubectl config set-credentials system:kube-scheduler \

--client-certificate=/etc/kubernetes/pki/scheduler.pem \

--client-key=/etc/kubernetes/pki/scheduler-key.pem \

--embed-certs=true \

--kubeconfig=/etc/kubernetes/scheduler.kubeconfig

# 设置 kubeconfig 的上下文,将集群、用户和命名空间绑定,定义 Scheduler 的访问环境。

kubectl config set-context system:kube-scheduler@kubernetes \

--cluster=kubernetes \

--user=system:kube-scheduler \

--kubeconfig=/etc/kubernetes/scheduler.kubeconfig

# 设置 kubeconfig 文件的默认上下文,确保 Scheduler 使用 system:kube-scheduler@kubernetes 上下文访问 API Server

kubectl config use-context system:kube-scheduler@kubernetes \

--kubeconfig=/etc/kubernetes/scheduler.kubeconfig3.3.9 生成 admin 的证书配置

# 生成一个 证书签名请求(Certificate Signing Request) 的配置文件,供 cfssl 工具使用

cat > /etc/kubernetes/pki/admin-csr.json << EOF

{

"CN": "admin",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "system:masters",

"OU": "Kubernetes-manual"

}

]

}

EOF

# 生成了管理员证书和密钥,用于 kubectl 访问 API Server 时进行身份认证

cfssl gencert \

-ca=/etc/kubernetes/pki/ca.pem \

-ca-key=/etc/kubernetes/pki/ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-profile=kubernetes \

/etc/kubernetes/pki/admin-csr.json | cfssljson -bare /etc/kubernetes/pki/admin

# 设置集群信息

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/kubernetes/pki/ca.pem \

--embed-certs=true \

--server=https://127.0.0.1:8443 \

--kubeconfig=/etc/kubernetes/admin.kubeconfig

# 设置用户凭证

kubectl config set-credentials kubernetes-admin \

--client-certificate=/etc/kubernetes/pki/admin.pem \

--client-key=/etc/kubernetes/pki/admin-key.pem \

--embed-certs=true \

--kubeconfig=/etc/kubernetes/admin.kubeconfig

# 绑定上下文

kubectl config set-context kubernetes-admin@kubernetes \

--cluster=kubernetes \

--user=kubernetes-admin \

--kubeconfig=/etc/kubernetes/admin.kubeconfig

# 启用当前上下文

kubectl config use-context kubernetes-admin@kubernetes --kubeconfig=/etc/kubernetes/admin.kubeconfig3.3.10 创建 kube-proxy 证书

# 生成 kube-proxy 证书签名请求文件 (CSR),这个文件会被用来生成证书请求

cat > /etc/kubernetes/pki/kube-proxy-csr.json << EOF

{

"CN": "system:kube-proxy",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "Beijing",

"L": "Beijing",

"O": "system:kube-proxy",

"OU": "Kubernetes-manual"

}

]

}

EOF

# 使用前面创建好的集群 CA 根证书来签发 kube-proxy 的客户端证书

cfssl gencert \

-ca=/etc/kubernetes/pki/ca.pem \

-ca-key=/etc/kubernetes/pki/ca-key.pem \

-config=/etc/kubernetes/pki/ca-config.json \

-profile=kubernetes \

/etc/kubernetes/pki/kube-proxy-csr.json | cfssljson -bare /etc/kubernetes/pki/kube-proxy

# 生成 kube-proxy 的 kubeconfig 文件, kube-proxy 在启动时需要使用一个 kubeconfig 文件来连接 API Server

# 设置集群信息

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/kubernetes/pki/ca.pem \

--embed-certs=true \

--server=https://127.0.0.1:8443 \

--kubeconfig=/etc/kubernetes/kube-proxy.kubeconfig

# 设置用户凭证

kubectl config set-credentials kube-proxy \

--client-certificate=/etc/kubernetes/pki/kube-proxy.pem \

--client-key=/etc/kubernetes/pki/kube-proxy-key.pem \

--embed-certs=true \

--kubeconfig=/etc/kubernetes/kube-proxy.kubeconfig

# 绑定上下文(Context)

kubectl config set-context kube-proxy@kubernetes \

--cluster=kubernetes \

--user=kube-proxy \

--kubeconfig=/etc/kubernetes/kube-proxy.kubeconfig

# 启用当前上下文

kubectl config use-context kube-proxy@kubernetes --kubeconfig=/etc/kubernetes/kube-proxy.kubeconfig3.3.11 生成 ServiceAccount(简称 SA)签名密钥对

# 生成文件 /etc/kubernetes/pki/sa.key —— ServiceAccount 私钥文件

openssl genrsa -out /etc/kubernetes/pki/sa.key 2048

# 生成文件 /etc/kubernetes/pki/sa.pub —— ServiceAccount 公钥文件

openssl rsa -in /etc/kubernetes/pki/sa.key -pubout -out /etc/kubernetes/pki/sa.pub4. 分发证书到其它节点

4.1 分发到 master 节点

k8s-master01

# 将生成的 ETCD 证书复制到其他节点

hosts='k8s-master02 k8s-master03'

user=root

for host in $hosts; do

echo $host;

ssh root@$host "mkdir -p /etc/kubernetes/pki/"

rsync --rsync-path="sudo rsync" /etc/kubernetes/pki/* $user@$host:/etc/kubernetes/pki/;

rsync --rsync-path="sudo rsync" /etc/kubernetes/admin.kubeconfig $user@$host:/etc/kubernetes/

rsync --rsync-path="sudo rsync" /etc/kubernetes/controller-manager.kubeconfig $user@$host:/etc/kubernetes/

rsync --rsync-path="sudo rsync" /etc/kubernetes/scheduler.kubeconfig $user@$host:/etc/kubernetes/

rsync --rsync-path="sudo rsync" /etc/kubernetes/kube-proxy.kubeconfig $user@$host:/etc/kubernetes/

done4.2 分发到 node 节点

k8s-master01

hosts='k8s-node01 k8s-node02'

user=root

for host in $hosts; do

echo $host;

ssh root@$host "mkdir -p /etc/kubernetes/pki/"

rsync --rsync-path="sudo rsync" /etc/kubernetes/pki/kube-proxy* $user@$host:/etc/kubernetes/pki/;

rsync --rsync-path="sudo rsync" /etc/kubernetes/kube-proxy.kubeconfig $user@$host:/etc/kubernetes/

done5. 查看证书

5.1 master 节点

$ ll /etc/kubernetes/pki/

total 140

-rw-r--r--. 1 root root 225 Oct 16 23:22 admin-csr.json

-rw-------. 1 root root 1679 Oct 16 23:25 admin-key.pem

-rw-r--r--. 1 root root 1025 Oct 16 23:25 admin.csr

-rw-r--r--. 1 root root 1432 Oct 16 23:25 admin.pem

-rw-r--r--. 1 root root 230 Oct 11 20:11 apiserver-csr.json

-rw-------. 1 root root 1675 Oct 11 20:17 apiserver-key.pem

-rw-r--r--. 1 root root 1565 Oct 11 20:17 apiserver.csr

-rw-r--r--. 1 root root 1948 Oct 11 20:17 apiserver.pem

-rw-r--r--. 1 root root 294 Oct 11 19:58 ca-config.json

-rw-r--r--. 1 root root 258 Oct 11 20:04 ca-csr.json

-rw-------. 1 root root 1679 Oct 11 20:04 ca-key.pem

-rw-r--r--. 1 root root 1062 Oct 11 20:04 ca.csr

-rw-r--r--. 1 root root 1342 Oct 11 20:04 ca.pem

-rw-------. 1 root root 1675 Oct 16 22:19 controller-manager-key.pem

-rw-r--r--. 1 root root 1082 Oct 16 22:19 controller-manager.csr

-rw-r--r--. 1 root root 1489 Oct 16 22:19 controller-manager.pem

-rw-r--r--. 1 root root 118 Oct 11 20:23 front-proxy-ca-csr.json

-rw-------. 1 root root 1679 Oct 16 21:19 front-proxy-ca-key.pem

-rw-r--r--. 1 root root 940 Oct 16 21:19 front-proxy-ca.csr

-rw-r--r--. 1 root root 1094 Oct 16 21:19 front-proxy-ca.pem

-rw-r--r--. 1 root root 87 Oct 16 21:22 front-proxy-client-csr.json

-rw-------. 1 root root 1679 Oct 16 21:25 front-proxy-client-key.pem

-rw-r--r--. 1 root root 903 Oct 16 21:25 front-proxy-client.csr

-rw-r--r--. 1 root root 1188 Oct 16 21:25 front-proxy-client.pem

-rw-r--r--. 1 root root 240 Oct 16 23:31 kube-proxy-csr.json

-rw-------. 1 root root 1675 Oct 16 23:31 kube-proxy-key.pem

-rw-r--r--. 1 root root 1045 Oct 16 23:31 kube-proxy.csr

-rw-r--r--. 1 root root 1456 Oct 16 23:31 kube-proxy.pem

-rw-r--r--. 1 root root 266 Oct 16 22:11 manager-csr.json

-rw-------. 1 root root 1704 Oct 16 23:34 sa.key

-rw-r--r--. 1 root root 451 Oct 16 23:34 sa.pub

-rw-r--r--. 1 root root 248 Oct 16 23:07 scheduler-csr.json

-rw-------. 1 root root 1679 Oct 16 23:08 scheduler-key.pem

-rw-r--r--. 1 root root 1058 Oct 16 23:08 scheduler.csr

-rw-r--r--. 1 root root 1464 Oct 16 23:08 scheduler.pem

$ ll /etc/kubernetes/

total 36

-rw-------. 1 root root 6341 Oct 16 23:26 admin.kubeconfig

-rw-------. 1 root root 6469 Oct 16 22:30 controller-manager.kubeconfig

-rw-------. 1 root root 6345 Oct 16 23:32 kube-proxy.kubeconfig

drwxr-xr-x. 2 root root 4096 Oct 16 23:34 pki

-rw-------. 1 root root 6401 Oct 16 23:14 scheduler.kubeconfig5.2 node 节点

$ ll /etc/kubernetes/pki/

total 16

-rw-r--r--. 1 root root 240 Oct 16 23:52 kube-proxy-csr.json

-rw-------. 1 root root 1675 Oct 16 23:52 kube-proxy-key.pem

-rw-r--r--. 1 root root 1045 Oct 16 23:52 kube-proxy.csr

-rw-r--r--. 1 root root 1456 Oct 16 23:52 kube-proxy.pem

$ ll /etc/kubernetes/

total 8

-rw-------. 1 root root 6345 Oct 16 23:52 kube-proxy.kubeconfig

drwxr-xr-x. 2 root root 103 Oct 16 23:52 pki五、K8S 系统组件配置

1. ETCD 配置

etcd 配置大致相同,注意修改每个 Master 节点的 etcd 配置的主机名和IP地址

官方文档:https://etcd.io/docs/v3.5/op-guide/configuration/

从 Github 获取配置文件示例 :https://github.com/etcd-io/etcd/blob/main/etcd.conf.yml.sample

配置项解读:

- name:指定了当前节点的名称,用于集群中区分不同的节点。

- data-dir:指定了 etcd 数据的存储目录。

- wal-dir:指定了 etcd 数据写入磁盘的目录。

- snapshot-count:指定了触发快照的事务数量。

- heartbeat-interval:指定了 etcd 集群中节点之间的心跳间隔。

- election-timeout:指定了选举超时时间。

- quota-backend-bytes:指定了存储的限额,0 表示无限制。

- listen-peer-urls:指定了节点之间通信的 URL,使用 HTTPS 协议。

- listen-client-urls:指定了客户端访问 etcd 集群的 URL,同时提供了本地访问的 URL。

- max-snapshots:指定了快照保留的数量。

- max-wals:指定了日志保留的数量。

- initial-advertise-peer-urls:指定了节点之间通信的初始 URL。

- advertise-client-urls:指定了客户端访问 etcd 集群的初始 URL。

- discovery:定义了 etcd 集群发现相关的选项。

- initial-cluster:指定了 etcd 集群的初始成员。

- initial-cluster-token:指定了集群的 token。

- initial-cluster-state:指定了集群的初始状态。

- strict-reconfig-check:指定了严格的重新配置检查选项。

- enable-v2:启用了 v2 API。

- enable-pprof:启用了性能分析。

- proxy:设置了代理模式。

- client-transport-security:客户端的传输安全配置。

- peer-transport-security:节点之间的传输安全配置。

- debug:是否启用调试模式。

- log-package-levels:日志的输出级别。

- log-outputs:指定了日志的输出类型。

- force-new-cluster:是否强制创建一个新的集群。

1.1 Master01 节点

如果要用 IPv6 那么把 IPv4 地址修改为 IPv6 即可

cat > /etc/etcd/etcd.config.yml << EOF

name: 'k8s-master01'

data-dir: /data/etcd

wal-dir: /data/etcd/wal

snapshot-count: 5000

heartbeat-interval: 100

election-timeout: 1000

quota-backend-bytes: 0

listen-peer-urls: 'https://10.20.1.101:2380'

listen-client-urls: 'https://10.20.1.101:2379,http://127.0.0.1:2379'

max-snapshots: 3

max-wals: 5

cors:

initial-advertise-peer-urls: 'https://10.20.1.101:2380'

advertise-client-urls: 'https://10.20.1.101:2379'

discovery:

discovery-fallback: 'proxy'

discovery-proxy:

discovery-srv:

initial-cluster: 'k8s-master01=https://10.20.1.101:2380,k8s-master02=https://10.20.1.102:2380,k8s-master03=https://10.20.1.103:2380'

initial-cluster-token: 'etcd-k8s-cluster'

initial-cluster-state: 'new'

strict-reconfig-check: false

enable-v2: true

enable-pprof: true

proxy: 'off'

proxy-failure-wait: 5000

proxy-refresh-interval: 30000

proxy-dial-timeout: 1000

proxy-write-timeout: 5000

proxy-read-timeout: 0

client-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

peer-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

peer-client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

debug: false

log-package-levels:

log-outputs: [default]

force-new-cluster: false

EOF1.2 Master02 节点

cat > /etc/etcd/etcd.config.yml << EOF

name: 'k8s-master02'

data-dir: /data/etcd

wal-dir: /data/etcd/wal

snapshot-count: 5000

heartbeat-interval: 100

election-timeout: 1000

quota-backend-bytes: 0

listen-peer-urls: 'https://10.20.1.102:2380'

listen-client-urls: 'https://10.20.1.102:2379,http://127.0.0.1:2379'

max-snapshots: 3

max-wals: 5

cors:

initial-advertise-peer-urls: 'https://10.20.1.102:2380'

advertise-client-urls: 'https://10.20.1.102:2379'

discovery:

discovery-fallback: 'proxy'

discovery-proxy:

discovery-srv:

initial-cluster: 'k8s-master01=https://10.20.1.101:2380,k8s-master02=https://10.20.1.102:2380,k8s-master03=https://10.20.1.103:2380'

initial-cluster-token: 'etcd-k8s-cluster'

initial-cluster-state: 'new'

strict-reconfig-check: false

enable-v2: true

enable-pprof: true

proxy: 'off'

proxy-failure-wait: 5000

proxy-refresh-interval: 30000

proxy-dial-timeout: 1000

proxy-write-timeout: 5000

proxy-read-timeout: 0

client-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

peer-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

peer-client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

debug: false

log-package-levels:

log-outputs: [default]

force-new-cluster: false

EOF1.3 Master03 节点

cat > /etc/etcd/etcd.config.yml << EOF

name: 'k8s-master03'

data-dir: /data/etcd

wal-dir: /data/etcd/wal

snapshot-count: 5000

heartbeat-interval: 100

election-timeout: 1000

quota-backend-bytes: 0

listen-peer-urls: 'https://10.20.1.103:2380'

listen-client-urls: 'https://10.20.1.103:2379,http://127.0.0.1:2379'

max-snapshots: 3

max-wals: 5

cors:

initial-advertise-peer-urls: 'https://10.20.1.103:2380'

advertise-client-urls: 'https://10.20.1.103:2379'

discovery:

discovery-fallback: 'proxy'

discovery-proxy:

discovery-srv:

initial-cluster: 'k8s-master01=https://10.20.1.101:2380,k8s-master02=https://10.20.1.102:2380,k8s-master03=https://10.20.1.103:2380'

initial-cluster-token: 'etcd-k8s-cluster'

initial-cluster-state: 'new'

strict-reconfig-check: false

enable-v2: true

enable-pprof: true

proxy: 'off'

proxy-failure-wait: 5000

proxy-refresh-interval: 30000

proxy-dial-timeout: 1000

proxy-write-timeout: 5000

proxy-read-timeout: 0

client-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

peer-transport-security:

cert-file: '/etc/kubernetes/pki/etcd/etcd.pem'

key-file: '/etc/kubernetes/pki/etcd/etcd-key.pem'

peer-client-cert-auth: true

trusted-ca-file: '/etc/kubernetes/pki/etcd/etcd-ca.pem'

auto-tls: true

debug: false

log-package-levels:

log-outputs: [default]

force-new-cluster: false

EOF1.4 创建 ETCD Service

master 01

cat > /usr/lib/systemd/system/etcd.service << EOF

[Unit]

Description=Etcd Service

Documentation=https://coreos.com/etcd/docs/latest/

After=network.target

[Service]

Type=notify

ExecStart=/usr/local/bin/etcd --config-file=/etc/etcd/etcd.config.yml

Restart=on-failure

RestartSec=10

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

Alias=etcd3.service

EOF命令解析:

该文件定义了 etcd 服务在 Linux 系统上的运行方式,使用 systemd 管理 etcd 进程的启动、停止、自动重启等行为。此配置是为 Kubernetes 高可用集群中的 etcd 节点(例如 k8s-master03)设计的,结合了 /etc/etcd/etcd.config.yml 配置文件运行 etcd。

After=network.target:定义服务在哪些 systemd 目标或单元启动后启动。network.target 表示网络服务可用。 影响:确保 etcd 在网络初始化后启动,因为 etcd 需要监听网络端口(2379/2380)进行客户端和节点间通信。如果网络不可用,etcd 可能启动失败

Type=notify:默认值:simple 描述:定义服务进程的类型。notify 表示主进程通过 sd_notify(3) 向 systemd 发送启动完成信号(etcd 支持此机制)。 影响:notify 允许 systemd 等待 etcd 完成初始化(如绑定端口、加入集群)后再标记服务为“运行”。

ExecStart=/usr/local/bin/etcd –config-file=/etc/etcd/etcd.config.yml

服务启动时执行的命令及其参数。运行 etcd 二进制,指定配置文件路径

Restart=on-failure:控制服务失败时的重启行为。on-failure 表示在进程异常退出(非零退出码)、超时或被信号终止时自动重启。

RestartSec=10:重启前的等待时间(秒)

LimitNOFILE=65536:设置进程的最大文件描述符数量(软限制和硬限制)。 影响:etcd 需处理大量网络连接(如 Kubernetes API 请求),默认值可能不足导致 “too many open files” 错误。65536 适合高负载集群,需确保系统级限制

WantedBy=multi-user.target:指定服务在哪个 systemd 目标启用。multi-user.target 表示多用户模式(非图形界面,通常为服务器默认运行级别)

Alias=etcd3.service:为服务创建别名,允许通过别名(如 systemctl start etcd3.service)操作服务

同步到其它Master节点

# 将生成的 ETCD Service复制到其他节点

hosts='k8s-master02 k8s-master03'

user=root

for host in $hosts; do

echo $host;

rsync --rsync-path="sudo rsync" /usr/lib/systemd/system/etcd.service $user@$host:/usr/lib/systemd/system/;

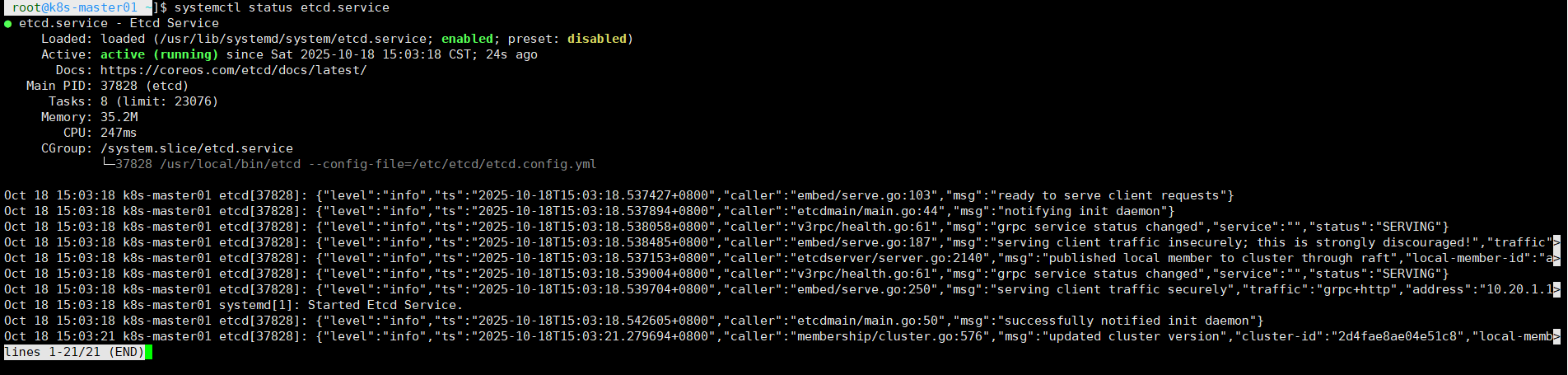

done1.5 启动 ETCD Service

hosts='k8s-master01 k8s-master02 k8s-master03'

user=root

for host in $hosts; do

echo $host;

echo "创建 etcd 证书目录"

ssh root@$host "mkdir -p /etc/kubernetes/pki/etcd"

echo "创建软连接"

ssh root@$host "ln -s /etc/etcd/ssl/* /etc/kubernetes/pki/etcd/"

ssh root@$host "systemctl daemon-reload"

ssh root@$host "systemctl enable --now etcd.service"

ssh root@$host "systemctl status etcd.service"

done

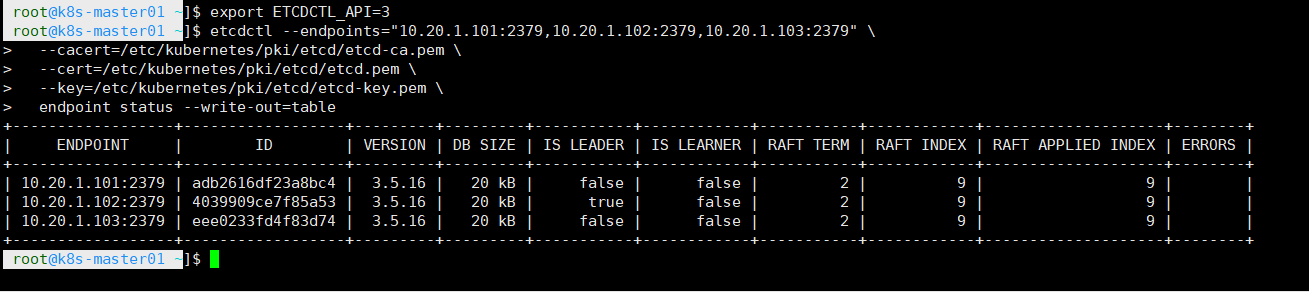

1.6 检查 ETCD 集群的健康状态

master01 、master02、master03

export ETCDCTL_API=3

etcdctl --endpoints="10.20.1.101:2379,10.20.1.102:2379,10.20.1.103:2379" \

--cacert=/etc/kubernetes/pki/etcd/etcd-ca.pem \

--cert=/etc/kubernetes/pki/etcd/etcd.pem \

--key=/etc/kubernetes/pki/etcd/etcd-key.pem \

endpoint status --write-out=table

命令解析:

该命令用于检查 etcd 集群的健康状态,是 Kubernetes 高可用部署中验证 etcd 集群运行情况的关键步骤

export ETCDCTL_API=3

明确设置 ETCDCTL_API=3 确保 etcdctl 使用 v3 协议,避免与 v2 兼容性问题

etcdctl:是 etcd 提供的命令行工具,用于与 etcd 集群交互(如查询状态、管理成员、执行操作)

–endpoints:指定 etcd 集群的客户端访问端点,包含三个节点的 IP 和端口(2379)

–cacert:指定 CA 证书路径 /etc/kubernetes/pki/etcd/etcd-ca.pem

–cert:客户端证书路径 /etc/kubernetes/pki/etcd/etcd.pem

–key:客户端私钥路径 /etc/kubernetes/pki/etcd/etcd-key.pem

2. Nginx 配置

2.1 编译安装

master 01

# 安装编译环境

yum install -y openssl-devel pcre-devel gcc

# 下载解压 nginx 二进制文件

wget http://nginx.org/download/nginx-1.25.3.tar.gz

tar xvf nginx-*.tar.gz

cd nginx-1.25.3

# 进行编译

./configure --prefix=/usr/local/nginx --sbin-path=/bin/ --user=nginx --group=nginx --with-stream --with-http_ssl_module --with-http_stub_status_module --with-http_gzip_static_module --with-pcre --without-http --without-http_uwsgi_module --without-http_scgi_module --without-http_fastcgi_module

make && make install

# 将编译好的 nginx 二进制包,拷贝到其它节点

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for host in $hosts; do

echo $host;

rsync -a --rsync-path="sudo rsync" /usr/local/nginx $user@$host:/usr/local/;

rsync --rsync-path="sudo rsync" /bin/nginx* $user@$host:/bin/;

done

# 验证

$ nginx -v

nginx version: nginx/1.25.32.2 nginx 配置文件

Master 01

# 写入配置文件(在所有主机上执行)

cat > /usr/local/nginx/conf/kube-nginx.conf <<EOF

worker_processes 1;

user nobody;

events {

worker_connections 1024;

}

stream {

upstream backend {

least_conn;

hash $remote_addr consistent;

server 10.20.1.101:6443 max_fails=3 fail_timeout=30s;

server 10.20.1.102:6443 max_fails=3 fail_timeout=30s;

server 10.20.1.103:6443 max_fails=3 fail_timeout=30s;

}

server {

listen 127.0.0.1:8443;

proxy_connect_timeout 1s;

proxy_pass backend;

}

}

EOF

# 将kube-nginx.conf,拷贝到其它 Master 节点

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for host in $hosts; do

echo $host;

rsync -a --rsync-path="sudo rsync" /usr/local/nginx/conf/kube-nginx.conf $user@$host:/usr/local/nginx/conf/;

done命令解析:

该命令用于创建 Nginx 配置文件 /usr/local/nginx/conf/kube-nginx.conf,配置 Nginx 作为 Kubernetes API 服务器的负载均衡器,处理 TCP 流量(端口 6443)

upstream backend

将本地 8443 端口的请求分发到三个 master 节点的 API 服务器的 6443 端口

least_conn;

选择当前活跃连接数最少的后端服务器进行负载均衡

hash $remote_addr consistent;

基于客户端 IP($remote_addr)进行一致性哈希,确保同一客户端始终连接到同一后端服务器

max_fails=3 fail_timeout=30s;

max_fails=3(失败 3 次后标记为不可用),fail_timeout=30s(标记不可用后 30 秒内不尝试)

6443 端口是 Kubernetes API 服务器(kube-apiserver)的默认端口,接受来自客户端(如 kubectl、kubelet、控制器等)的 HTTPS 请求。

8443 端口是 kube-apiserver 的代理端口,用于接收请求,并将请求转发到真正的 6443 端口

2.3 配置 Nginx Service

Master 01

cat > /etc/systemd/system/kube-nginx.service <<EOF

[Unit]

Description=kube-apiserver nginx proxy

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

Type=forking

ExecStartPre=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx -t

ExecStart=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx

ExecReload=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx -s reload

PrivateTmp=true

Restart=always

RestartSec=5

StartLimitInterval=0

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

EOF命令解析:

创建一个 systemd 单元文件,用于管理系统服务。这个文件定义了一个名为 kube-nginx 的服务,负责运行 Nginx 作为 Kubernetes API 服务器的负载均衡代理

Nginx 在这里被配置为 TCP 负载均衡器(非 HTTP),运行在每个 master 节点(k8s-master01、k8s-master02、k8s-master03,IP 分别为 192.168.10.11、12、13),监听本地 127.0.0.1:8443 端口,并将请求分发到三个 master 节点的 API 服务器端口 6443。

After=network.target :基本网络接口配置完成

After=network-online.target :网络完全在线(可路由外部)

Wants=network-online.target :声明弱依赖,建议(但不强制)在 network-online.target 启动后运行服务

Type=forking:

forking 表示主进程派生子进程(如 Nginx master 进程派生 worker),systemd 跟踪子进程 PID(从 PID 文件读取)

ExecStartPre=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx -t

启动前执行的预命令。-t 测试配置文件语法

ExecStart=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx

启动服务的核心命令,运行 Nginx。 博客上下文:启动 Nginx,加载 kube-nginx.conf,启用 TCP 负载均衡(8443 到 6443)

ExecReload=/bin/nginx -c /usr/local/nginx/conf/kube-nginx.conf -p /usr/local/nginx -s reload

重新加载配置的命令(systemctl reload kube-nginx)。-s reload 发送信号平滑重载

PrivateTmp=true :为服务分配私有 /tmp 和 /var/tmp 目录,隔离系统临时文件

Restart=always :失败或退出时自动重启。always 表示无论原因都重启

RestartSec=5 :重启前等待时间(秒)

StartLimitInterval=0 :重启时间窗口(秒),0 表示无限制。

LimitNOFILE=65536 :最大文件描述符数,防止 “too many open files” 错误

WantedBy=multi-user.target : 服务在多用户模式下启用, 确保 Nginx 随系统启动。

2.4 设置 Nginx 开机自启

# 刷新系统服务

systemctl daemon-reload

# 设置 kube-nginx 开机自启

systemctl enable --now kube-nginx.service

# 查看 nginx 启动状态

systemctl status kube-nginx.service将 kube-nginx.service 同步到其它服务器

# 将kube-nginx.service,拷贝到其它 Master 节点,并让Nginx开机自启

hosts='k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for host in $hosts; do

echo $host;

rsync -a --rsync-path="sudo rsync" /etc/systemd/system/kube-nginx.service $user@$host:/etc/systemd/system/;

ssh root@$host "systemctl daemon-reload"

ssh root@$host "systemctl enable --now kube-nginx.service"

ssh root@$host "systemctl status kube-nginx.service"

done3. kube-apiserver 配置

3.1 创建必要的目录

master01

# 所有 k8s 节点创建以下目录

hosts='k8s-master01 k8s-master02 k8s-master03 k8s-node01 k8s-node02'

user=root

for host in $hosts; do

echo $host;

ssh root@$host "mkdir -p /etc/kubernetes/manifests/ /etc/systemd/system/kubelet.service.d /var/lib/kubelet /var/log/kubernetes"

done3.2 配置 kube-apiserver.service

官方文档:https://kubernetes.io/zh-cn/docs/reference/command-line-tools-reference/kube-apiserver/

master01

cat > /usr/lib/systemd/system/kube-apiserver.service << EOF

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes

After=network.target

[Service]

ExecStart=/usr/local/bin/kube-apiserver \\

--v=2 \\

--allow-privileged=true \\

--bind-address=0.0.0.0 \\

--secure-port=6443 \\

--advertise-address=10.20.1.101 \\

--service-cluster-ip-range=10.96.0.0/12,fd00:1111::/112 \\

--service-node-port-range=30000-32767 \\

--etcd-servers=https://10.20.1.101:2379,https://10.20.1.102:2379,https://10.20.1.103:2379 \\

--etcd-cafile=/etc/etcd/ssl/etcd-ca.pem \\

--etcd-certfile=/etc/etcd/ssl/etcd.pem \\

--etcd-keyfile=/etc/etcd/ssl/etcd-key.pem \\

--client-ca-file=/etc/kubernetes/pki/ca.pem \\

--tls-cert-file=/etc/kubernetes/pki/apiserver.pem \\

--tls-private-key-file=/etc/kubernetes/pki/apiserver-key.pem \\

--kubelet-client-certificate=/etc/kubernetes/pki/apiserver.pem \\

--kubelet-client-key=/etc/kubernetes/pki/apiserver-key.pem \\

--service-account-key-file=/etc/kubernetes/pki/sa.pub \\

--service-account-signing-key-file=/etc/kubernetes/pki/sa.key \\

--service-account-issuer=https://kubernetes.default.svc.cluster.local \\

--kubelet-preferred-address-types=InternalIP,ExternalIP,Hostname \\

--enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount,DefaultStorageClass,DefaultTolerationSeconds,NodeRestriction,ResourceQuota \

--authorization-mode=Node,RBAC \\

--enable-bootstrap-token-auth=true \\